A Meta forneceu alguns insights sobre o seu novo design de data center, com air e liquid cooling para cargas de trabalho padrão e de alta densidade.

No final do ano passado, a DCD divulgou a notícia de que a Meta estava cancelando ou pausando projetos de Data Center em todo o mundo para oferecer suporte a cargas de trabalho de inteligência artificial em meio a um pivô de IA generativa.

A Meta é uma grande operadora de data center. O campus de Prineville, da empresa, é o maior data center operacional do mundo. Somente no último trimestre, o capex da Meta para data centers, servidores e escritórios atingiu US$ 7,1 bilhões, com a organização alertando os investidores de que uma construção de IA seria cara.

Data centers de última geração

A empresa precisou repensar as suas instalações depois de apostar em CPUs e nos seus próprios chips internos para lidar com as cargas de trabalho tradicionais e as de IA. Mas, como o uso da IA cresceu e se tornou um ponto crítico de concorrência para as grandes empresas de tecnologia, as CPUs não conseguiram acompanhar o ritmo.

O chip interno da Meta, por sua vez, não conseguiu atingir as metas internas e o lançamento planejado para o ano passado foi descartado. Agora a empresa espera adotar as GPUs e fez uma nova tentativa de criar um chip interno. Ela também revelou um chip interno para transcodificação de vídeo, semelhante ao semicondutor Argos do YouTube.

“Estamos experimentando um crescimento na tecnologia de IA, [portanto] precisamos garantir que o nosso Data Center possa se adaptar a algo que ainda está evoluindo. E precisamos escalá-lo em 4 vezes, aproximadamente", disse Alan Duong, diretor global de engenharia estratégica de Data Center da Meta, em um evento para a imprensa que detalhou o "Design de data center de próxima geração" da empresa.

Duong observou que a IA "torna a inovação no design do data center realmente complexa", pois a empresa precisa equilibrar o design das cargas de trabalho atuais com as necessidades desconhecidas do futuro. "Por exemplo, nos próximos quatro anos, poderemos ver um crescimento de uma vez e meia a duas vezes no consumo de energia por acelerador, e aproximadamente uma vez e meia para memória de alta largura de banda."

A Meta planeja iniciar a construção do primeiro dos seus Data Centers de próxima geração "hoje ou este ano", disse Duong. "Portanto, se estivermos apenas começando a construção desse Data Center, quando terminarmos, poderemos estar obsoletos [a menos que estejamos preparados para o futuro]."

O Data Center pode precisar suportar diferentes implementações de “white space”: "Dependendo das necessidades dos nossos serviços e produtos, podemos ver clusters menores em escala de 1.000 aceleradores a potencialmente mais de 30.000 para trabalhos muito maiores. Cada uma dessas configurações, bem como o acelerador que utilizamos, exigirá uma abordagem ligeiramente diferente para os projetos de hardware e sistemas de rede."

Para o treinamento em IA, os servidores são "construídos em torno de aceleradores e do sistema de rede operando como um só", continuou ele. "Isso também permite eficiência na nossa implementação de fibra, porque precisamos de uma fibra significativa para interconectar esses servidores. Portanto, colocá-los mais próximos nos permitirá obter algumas eficiências nesse sentido."

As GPUs exigem muito mais energia do que as CPUs (e, portanto, mais resfriamento), algo que o projeto anterior do Data Center da Meta não suportava.

"Esses servidores vão exigir diferentes tipos de resfriamento", disse Duong. Embora as GPUs de alta densidade precisem de resfriamento líquido, o Meta ainda terá uma grande quantidade de cargas de trabalho tradicionais que podem existir em CPUs, que ainda podem usar resfriamento a ar.

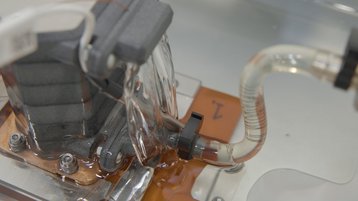

A instalação como um todo usará resfriamento a água, mas ela será usada apenas para a unidade de tratamento de ar na maioria dos servidores. Em vez disso, um número crescente de servidores de treinamento de IA receberá água de uma unidade de distribuição de resfriamento e, em seguida, diretamente para o chip. Parte dessa infraestrutura de resfriamento é da ColdLogix, segundo a DCD. Uma imagem compartilhada com a DCD parece mostrar alguma forma de resfriamento por imersão, mas a Meta não fez nenhuma menção a isso durante o seu anúncio. A DCD entrou em contato com a empresa para obter esclarecimentos.

"Vamos implementar apenas uma pequena porcentagem de líquido para resfriamento de chip no primeiro dia", disse Duong. "E vamos ampliá-la conforme a necessidade. Isso significa um planejamento e uma colocação de rack mais complexos no início - nunca tivemos que fazer isso no passado. Portanto, esse é um processo muito complicado para nós, mas que permite economizar algum capital."

Ele também admitiu que "os requisitos de prova futura para resfriamento a ar e a água não nos favorecem em termos de eficiência energética, redução de custos ou implantação mais rápida de Data Centers. Portanto, tivemos que fazer algumas compensações à medida que avançávamos no projeto".

Uma possível troca é que a empresa usará menos geradores a diesel e outros tipos de resiliência física e, em vez disso, dependerá mais da resiliência de software e de algum buffer de hardware. "Mas isso significa que assumiremos um risco desconhecido associado ao software para nossas cargas de trabalho de IA", disse Duong. "Ainda estamos aprendendo sobre isso, pois estamos implementando em escala. Assim, à medida que aprendermos mais, poderemos ajustar a nossa estratégia."

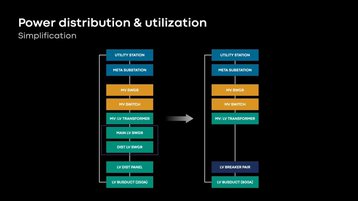

O novo design também fornece infraestrutura de energia mais próxima do rack do servidor, disse Duong. "Será mais simples e mais eficiente com o novo design. Estamos eliminando ao máximo equipamentos na nossa cadeia de distribuição de energia... Estamos eliminando o painel de distribuição de baixa tensão, que cria um gargalo de capacidade. A eliminação disso permite que o rack do servidor cresça em densidade no futuro com pequenas modificações na infraestrutura, e continua permitindo uma maior utilização de energia".

A empresa alega que os seus Data Centers atuais utilizam cerca de 70% ou mais da energia que implementam, mas não informou qual será o alcance dos novos projetos.

De modo geral, a empresa prevê que o Data Center de última geração será 31% mais econômico. "E poderemos construí-lo duas vezes mais rápido para uma região completa, se compararmos com o nosso Data Center de geração atual", disse Duong.

O supercomputador da Meta

Além do projeto principal dos futuros Data Centers, a Meta opera o "AI Research SuperCluster" desde o início de 2022, que é uma atualização de um supercomputador anterior.

O RSC foi atualizado com quase 10.000 GPUs Nvidia V100 Tensor Core, para um total de 16.000. A empresa disse que também criou um mecanismo de armazenamento personalizado, em parceria com a Penguin Computing e a Pure Storage.

O RSC é baseado em 2.000 sistemas Nvidia DGX A100, conectados por meio de uma rede fabric Nvidia Quantum InfiniBand de 16 Tb/s.

Aprendemos "algumas lições, que incorporamos à segunda fase do cluster", disse o engenheiro de software da Meta, Kalyan Saladi. "A primeira é a taxa de falhas. As taxas de falha de hardware foram mais altas do que prevíamos, e isso exigiu que criássemos melhores mecanismos de correção de detecção para garantir um cluster estável e confiável e oferecer uma experiência perfeita aos nossos pesquisadores. Em seguida, nosso tecido - um dos maiores tecidos IP planos do mundo, especialmente nessa escala - nos obrigou a fazer um trabalho pioneiro e inovador para encontrar os gargalos de desempenho, ajustar e sustentar o desempenho do cluster por um longo período. E essas lições foram incorporadas à forma como desenvolvemos o restante do cluster na fase dois."

A empresa também facilitou para as equipes a execução de vários projetos no RSC ao mesmo tempo.

"Por que criar um Super Cluster personalizado em vez de usar a tecnologia de Data Center existente que a Meta implantou em todo o mundo?" perguntou Saladi.

"Na verdade, tudo se resume a entender e perceber as demandas exclusivas que o treinamento de IA em grande escala impõe à infraestrutura. Isso se traduz na necessidade de controlar os parâmetros físicos", disse Saladi.

"O número um é a tecnologia de resfriamento. O resfriamento baseado em fluxo de ar não estava atendendo às nossas necessidades de treinamento em IA em grande escala. Por isso, tivemos que optar pelo resfriamento líquido, o que foi um desvio dos Data Centers de produção Meta. Dada a densidade do rack, dado o número de GPUs que queríamos colocar no edifício do Data Center, isso significou que os requisitos de energia se desviaram significativamente da configuração de produção. Mas há mais um aspecto importante, que é a rede de back-end plana especializada. Essa é uma rede de baixa latência e alta largura de banda com restrições nos parâmetros físicos de até onde você pode espalhar essas GPUs. Quando juntamos esses três aspectos, decidimos que precisávamos de um cluster personalizado."

Os chips da Meta

Embora a sua primeira incursão em semicondutores de IA não tenha saído como planejada, a Meta espera construir o seu próprio chip (semelhante ao TPU do Google, ao Trainium da AWS e ao Athena da Microsoft).

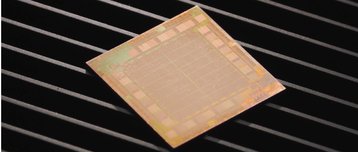

O chip Meta Training and Inference Accelerator (MTIA) espera, como o nome sugere, lidar com ambas as cargas de trabalho de IA. O semicondutor é baseado no nó de processo de 7 nm e é fabricado pela TSMC.

Ele funciona a 800 megahertz, tem cerca de 370 milímetros quadrados e um pequeno orçamento de energia de 25 watts. Ele fornece 102 Tops de computação de precisão inteira (8 bits) ou 51,2 teraflops de computação de precisão FP16.

Amin Firoozshahian, cientista de pesquisa de infraestrutura da Meta, disse: "É um chip otimizado para executar as cargas de trabalho que nos interessam e adaptado especificamente para essas necessidades".

Ele foi projetado especialmente para o PyTorch, uma estrutura de aprendizado de máquina de código aberto lançada inicialmente pela Meta. Com o anúncio do novo chip, a empresa detalhou o PyTorch 2.0.

Além do MTIA, a empresa desenvolveu o Meta Scalable Video Processor (MSVP).

"O MSVP processa vídeo nove vezes mais rápido do que os codificadores de software tradicionais - a mesma qualidade de vídeo com metade da energia", disse Harikrishna Reddy, gerente técnico principal do projeto.

"O MSVP eleva o nível da qualidade de redimensionamento de quadros e da qualidade de codificação de vídeo, e somos os primeiros do setor a oferecer suporte a métricas objetivas de qualidade em hardware. Portanto, para cada codificação de vídeo que fazemos, também calculamos uma pontuação de qualidade usando métricas padrão como SSIM, PSNR ou MSSIM. E, em seguida, usamos essa pontuação de qualidade para indicar como esse vídeo será percebido quando um usuário o vir no vídeo. Imagine fazer isso em escala em bilhões de vídeos", concluiu.