A Microsoft está implementando o equivalente a cinco supercomputadores Eagle de 561 petaflops por mês, de acordo com o CTO do Azure, Mark Russinovich.

O Eagle apareceu pela primeira vez no ranking Top500 dos supercomputadores mais poderosos do mundo em novembro passado, ocupando o terceiro lugar. Com um desempenho de 561,2 petaflops (HP Linpack), o sistema da Microsoft é também o supercomputador em nuvem mais poderoso do mundo.

“Garantimos esse lugar [no Top500] com 14.400 GPUs Nvidia H100 em rede e 561 petaflops de computação, o que na época representava apenas uma fração da escala final desse supercomputador”, disse Russinovich no Microsoft Build.

“Nosso sistema de IA agora é muito maior e está mudando a cada dia e a cada hora”, acrescentou, embora o Eagle tenha tido um desempenho igualmente bom no ranking Top500 deste mês, sugerindo que Russinovich estava falando sobre a capacidade de computação do Azure de forma mais ampla.

“Hoje, apenas seis meses depois, estamos implementando o equivalente a cinco desses supercomputadores todos os meses”.

Isso representaria o equivalente a 72.000 GPUs H100 por mês, espalhadas pelo crescente espaço do Data Center da empresa, e um total de 2,8 exaflops de computação.

“Nosso cabeamento de alta velocidade e a InfiniBand que conecta nossas GPUs seriam longos o suficiente para dar a volta à Terra pelo menos cinco vezes”, acrescentou. A circunferência do mundo é de cerca de 40.000 quilômetros, o que significa mais de 200.000 quilômetros de fiação.

Em outra parte do Build, o CTO da Microsoft, Kevin Scott, deu mais informações sobre os próximos supercomputadores da empresa, mas foi muito menos específico sobre os números.

“Eu só queria, sem mencionar números, o que é difícil de fazer, dar a todos uma noção da escala desses sistemas”, disse Scott. “Em 2020, construímos nosso primeiro supercomputador de IA para OpenAI. É o ambiente de supercomputação que o GPT-3 construiu”.

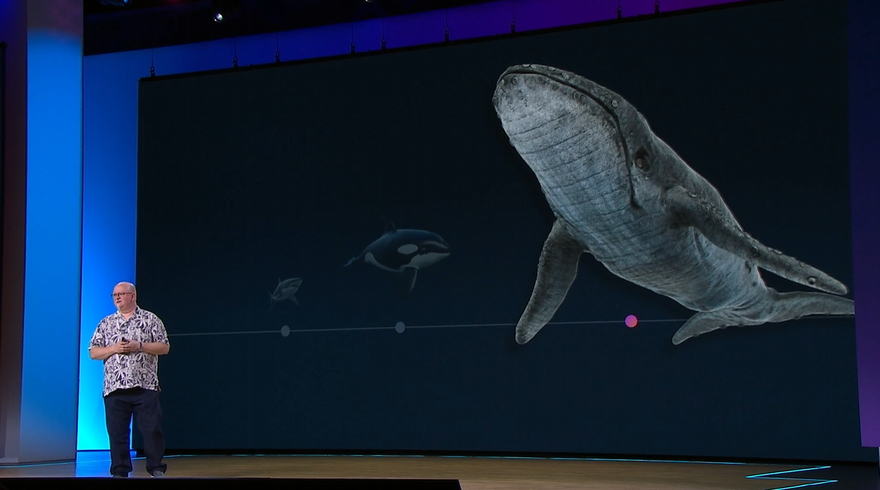

Em vez de números, Scott usou a fauna marinha como uma representação de escala. Esse sistema, segundo ele, poderia se parecer com um tubarão, pelo menos em tamanho.

“O próximo sistema que construímos, em escala, é do tamanho de uma orca. Esse é o sistema que entregamos em 2022 que treinou o GPT-4”, continuou, provavelmente fazendo referência ao sistema Eagle. Embora sua métrica esteja longe de ser exata, as orcas são duas vezes maiores e três vezes mais pesadas que os grandes tubarões brancos.

“O sistema que acabamos de implementar é tão grande, em termos de escala, quanto uma baleia”. Expandindo a métrica, uma baleia azul (a baleia que ele retratou) é mais do que o dobro do comprimento de uma orca e cerca de 25 vezes mais pesada.

Scott também disse que o desenvolvimento de modelos mostrou que ainda havia uma ligação clara entre a quantidade de computação usada para desenvolver novos modelos e as capacidades de que eles são capazes. “E é possível construir muita IA com um supercomputador do tamanho de uma baleia”, disse ele.

“Então, uma das coisas que eu quero que as pessoas realmente pensem claramente é que o próximo show está chegando, e esse supercomputador do tamanho de uma baleia está trabalhando duro agora para construir o próximo conjunto de recursos que vamos implementar”.

No início do ano, foi relatado que a Microsoft e a OpenAI consideravam construir um supercomputador 'Stargate' de 100 bilhões de dólares (515 bilhões de reais), mas no mês passado Scott chamou as especulações sobre supercomputação de “comicamente erradas”.