A Nvidia revelou sua próxima família de GPUs: Blackwell.

A empresa afirmou que a nova arquitetura de GPU permitirá aos clientes construir e executar IA generativa em tempo real em grandes modelos de linguagem com trilhões de parâmetros a um custo e consumo de energia 25 vezes menor do que seu antecessor, a série Hopper.

A Amazon, Google, Meta, Microsoft, Oracle Cloud e OpenAI estão entre as empresas que confirmaram que implantarão GPUs Blackwell ainda esse ano.

A Blackwell recebeu o nome de David Harold Blackwell, um matemático especializado em teoria dos jogos e estatística, e o primeiro estudioso negro a entrar na Academia Nacional de Ciências.

“Por três décadas, buscamos a computação acelerada, com o objetivo de permitir avanços transformadores, como aprendizado profundo e inteligência artificial”, disse Jensen Huang, fundador e CEO da Nvidia.

“A IA generativa é a tecnologia definidora do nosso tempo. Os GPUs da Blackwell são o motor que impulsionará essa nova revolução industrial. Ao trabalhar com as empresas mais dinâmicas do mundo, realizaremos a promessa da IA para todos os setores”.

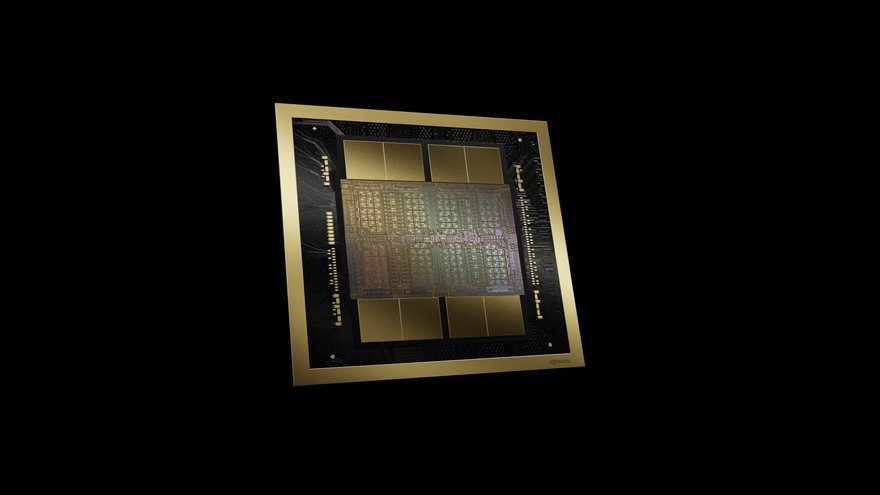

Os GPUs da arquitetura Blackwell são fabricadas usando um processo TSMC 4NP de limite de dois retículos personalizado com matrizes de GPU conectadas por meio de um link chip-to-chip de 10 TBps em um único GPU unificado.

O GPU tem 208 bilhões de transistores, um aumento em relação aos 80 bilhões da série Hopper.

A Blackwell inclui um mecanismo transformador de segunda geração e novos recursos de inferência de IA de ponto flutuante de 4 bits.

Também possui um novo mecanismo dedicado à confiabilidade, disponibilidade e capacidade de serviço, com manutenção preventiva baseada em IA para executar diagnósticos e prever problemas de confiabilidade.

A Blackwell tem um motor de descompressão dedicado para acelerar consultas de banco de dados e “recursos avançados de computação sensível” não revelados.

Tal como acontece com a série Hopper, a Blackwell estará disponível como um 'Superchip': dois GPUs B200 e um CPU Nvidia Grace através de uma ligação chip-to-chip de 900GBps.

O Superchip GB200 oferece um aumento de desempenho de até 30x em comparação com o GPU Nvidia H100 para cargas de trabalho de inferência LLM e reduz o custo e o consumo de energia em até 25 vezes, disse a Nvidia.

“A Blackwell oferece enormes avanços em desempenho e acelerará nossa capacidade de fornecer modelos de ponta. Estamos entusiasmados em continuar trabalhando com a Nvidia para melhorar a computação de IA”, disse Sam Altman, CEO da OpenAI.

Elon Musk, CEO da Tesla e da xAI, acrescentou: “Atualmente, não há nada melhor do que o hardware da Nvidia para IA”.

De acordo com a Nvidia, o B100, B200 e GB200 rodam entre 700W e 1200W, dependendo do SKU e do tipo de resfriamento utilizado.