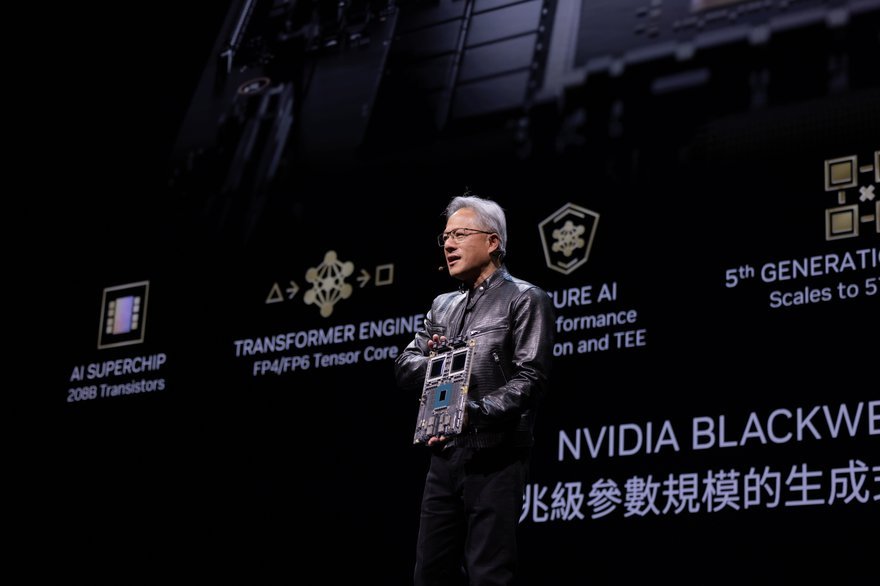

O CEO da Nvidia, Jensen Huang, usou seu discurso na Computex em Taiwan para divulgar o próximo roteiro de semicondutores da empresa, em que uma nova família de produtos será lançada a cada ano.

Também anunciou que o sucessor da arquitetura de chips Blackwell da Nvidia se chama Rubin e estará disponível a partir de 2026.

Embora tenha fornecido pouquíssimos detalhes técnicos sobre os chips, Huang revelou que o portfólio da Rubin incluirá novas GPUs, uma nova CPU baseada em Arm chamada Vera e chips de rede avançados contendo o switch convergente InfiniBand/Ethernet X1600.

“Nossa empresa tem um ritmo de um ano. Nossa filosofia básica é muito simples: construir toda a escala do Data Center, desagregar e vender peças para ele no ritmo de um ano e levar tudo aos limites da tecnologia”, explicou Huang durante seu discurso de abertura.

Além de aumentar seu ciclo de lançamento de GPU de dois em dois anos para anualmente, Huang também anunciou que a Nvidia acelerará seu cronograma de lançamento de produtos de rede, e a empresa está planejando lançar novos produtos Spectrum-X a cada ano.

O Spectrum-X, que estreou em maio de 2023, é uma plataforma de rede acelerada para cargas de trabalho de IA generativas e a Nvidia afirmou que é a primeira oferta Ethernet projetada especificamente para IA. A empresa afirma que acelera o desempenho da rede de IA generativa em 1,6 vezes em relação às estruturas Ethernet tradicionais.

Em um comunicado, a Nvidia disse que cada nova versão ofereceria “maior largura de banda e portas” além de “software aprimorado e conjuntos de recursos de programação para melhorar o desempenho da rede AI Ethernet”.

“A IA generativa está remodelando as indústrias e abrindo novas oportunidades de inovação e crescimento”, disse Huang aos participantes do evento. “Hoje estamos à beira de uma grande mudança na computação... a intersecção da IA e da computação acelerada redefinirá o futuro”.

Fábricas de IA e Computação Acelerada

Em outra parte de seu discurso de duas horas de duração, Huang revelou que empresas como a Asus, Ingrasys, Inventec, QCT, Supermicro e Wiwynn estavam fazendo parceria com a Nvidia para oferecer o que ele chamou de fábricas de IA.

Alimentadas pela arquitetura Blackwell da empresa, essas assim chamadas fábricas consistem em sistemas de IA para aplicativos em nuvem, locais, integradas e Edge, com ofertas que variam de GPUs únicas a múltiplas, processadores baseados em x86 e Grace e processadores aéreos para tecnologia de resfriamento líquido.

Huang também usou seu discurso para lançar a nova plataforma GB200 NVL2 para Nvidia MGX. Projetada para trazer recursos de IA generativa para o Data Center e consistindo em duas GPUs Blackwell e duas GPUs Grace, a plataforma fornecerá 40 petaflops de desempenho de IA em 144 núcleos de CPU Arm Neoverse e 1,3 terabytes de memória.

A Nvidia disse que a plataforma oferece “desempenho incomparável”, fornecendo inferência LLM 5x mais rápida, pesquisa vetorial de banco de dados vetorial 9x mais rápida e processamento de dados 18x mais rápido em comparação com as ofertas tradicionais de CPU e GPU.

“A próxima revolução industrial começou. Empresas e países estão fazendo parceria com a NVIDIA para mudar de Data Centers tradicionais de bilhões de dólares para computação acelerada e construir um novo tipo de Data Center (fábricas de IA) para produzir um novo produto: inteligência artificial”, disse Huang. “De fabricantes de servidores, redes e infraestrutura a desenvolvedores de software, toda a indústria está se preparando para que a Blackwell acelere a inovação impulsionada por IA em todos os campos”.

Mais sobre Canal Gestão & Operação

-

-

-

Discussion Brunch Briefing - TI Descentralizada