A era do 400G (como é chamada a taxa de transferência de 400 Gb/s) dentro dos data centers começou em 2017 e, desde então, não parou de crescer em opções. Embora estivesse disponível comercialmente algum tempo antes, o início dessa nova era foi marcado pela aprovação da interface 400GBASE-SR16 pelo grupo 802.3 Ethernet do IEEE. Naquela época, o canal base disponível era de 25 Gb/s e a multiplicação por 16 resultou no desejado 400 Gb/s, na distância de até 100 metros, usando um conector MPO de 32 fibras - algo bastante complicado de fabricar, testar e manter.

Em março de 2020, foi aprovada a interface 400GBASE-SR4.2, com diversas novidades. Uma delas é o uso de canal base de 50 Gb/s em PAM4 (Pulse-Amplitude Modulation 4 level) e, pela primeira vez em um padrão, mais de um comprimento de onda foi inserido em fibra óptica multimodo, aproveitando as vantagens da recém-desenvolvida OM5 para alcançar 150 metros. Os esforços para ampliar o leque de 400G continuam em grupos de trabalho que desenvolvem interfaces de curtas distâncias e baixo custo, para conexão de servidores, até aquelas para distâncias de 80 quilômetros, que possibilitarão a conexão de data centers para sincronização de conteúdo e serviços de alta demanda como vídeo, jogos e conferências.

Mas se as interfaces 400G parecem estar tecnicamente maduras e diversificadas e, ao mesmo tempo, devem experimentar um aumento de demanda de mercado nos próximos anos, o que pode vir depois?

Existem várias iniciativas acontecendo em paralelo, em diversas frentes. A opção mais popular parece ser a de 800 Gb/s (800G), mas há considerações sobre 1,6 Tb/s. Essa discussão, que já estava acontecendo, foi potencializada pela publicação do Bandwidth Assessment Report II (BWA) pelo IEEE, em abril de 2020, que reúne as tendências de crescimento da demanda em várias aplicações, tendo como base a taxa de 400 Gb/s em comparação com 800 Gb/s e 1,6 Tb/s.

O aumento de velocidade, em geral, acontece por uma multiplicação de "dimensões" que são impactadas diretamente pelos fatores custo e viabilidade técnica. Entre os desafios para se alcançar velocidades superiores a 400G, destacam-se:

Canal base de 100 Gb/s ou maior: até meados de 2021, deverá estar padronizado o canal básico elétrico de 100 Gb/s e suas multiplicações 200 Gb/s e 400 Gb/s. Essa pode ser a primeira opção para uma interface 800 Gb/s, mediante a paralelização da velocidade em 8 canais. Isso pode ser feito usando mais fibras ópticas: nesse caso, seriam 16 ou ainda mais de um comprimento de onda por fibra, levando assim mais canais, como na 400GBASE-SR4.2. Mas uma opção bastante interessante é o desenvolvimento de um canal base de 200 Gb/s. Dessa maneira, os 800 Gb/s seriam alcançados por uma multiplicação do canal por 4, reduzindo a complexidade no nível do meio de transmissão. Nesse caso, a complexidade seria levada para a sinalização (é possível continuar com o PAM4 ou ordens maiores) e correção de erros com consequências para o processamento. O desafio é a busca do equilíbrio entre a viabilidade técnica e econômica para um novo canal base.

Meio de transmissão e conectividade: outra balança que deve ser equilibrada e que depende diretamente do canal base. Um canal base de 200 Gb/s requer metade do meio exigido pelo canal de 100 Gb/s. Essa é a principal mudança entre as interfaces 400GBASE-SR16 (16x25 Gb/s) e 400GBASE-SR8 (8x50 Gb/s). Outro exemplo que ilustra como as dimensões são usadas, está na diferença entre as interfaces 400GBASE-SR8 e 400GBASE-SR4.2. Ambas usam o canal base de 50 Gb/s e multiplicam por 8 para alcançar os 400 Gb/s. A diferença é que a primeira usa um canal por par de fibra, o que demanda 16 fibras, enquanto a 400GBASE-SR4.2 coloca 2 canais por par de fibra em comprimentos de onda diferentes, exigindo assim apenas 8 fibras. A conectividade fica simplificada na segunda opção, pois usa um conector MPO de 8 fibras (a primeira, de 16 fibras). Por outro lado, é mais complexo fabricar um transceiver que usa dois comprimentos de onda em cada fibra. Essa mesma consideração pode ser feita para se chegar a 800 Gb/s, por exemplo. Supondo duas opções de canal base e duas de multiplexação por comprimento de onda teríamos, eventualmente, quatro métodos de conectividade e uso do meio físico.

O formato do transceiver: o desenvolvimento de novos transceivers tem procurado antecipar-se às necessidades da indústria, enfrentando o desafio de acomodar a maior potência e dissipação térmica, exigida pelo processamento em maiores velocidades, e a necessidade de ocupar pouco espaço, uma vez que a densidade de conexões é cada vez maior. Os novos formatos que são candidatos naturais a acomodar as próximas interfaces são o OSFP (Octal Small Form-Factor Pluggable) e o QSFP-DD (Quad Small Form-factor Pluggable Double Density). Ambos foram concebidos com 8 canais para aplicação direta de 400 Gb/s (8X50 Gb/s), mas já foram adotados pelos MSAs (Multi-Source Agreements) para 800G.

Como alternativa aos formatos “plugáveis” de tranceivers, estão em desenvolvimento métodos de conexão óptica direta nas placas de comunicação, como propõe a iniciativa COBO - Consortium for On-Board Optics. Nesse caso, a conexão óptica é feita diretamente na placa, próximo ao chipset, devendo economizar bastante espaço na frente dos switches.

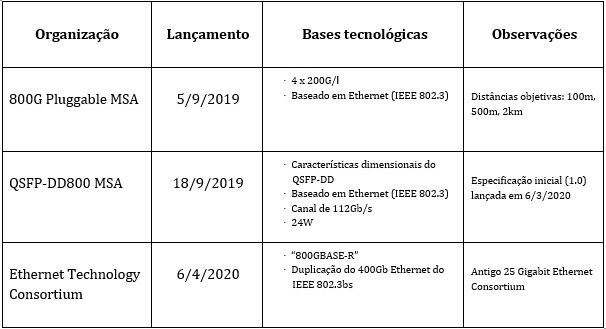

Alguns acordos de compatibilidade e especificação entre fabricantes (MSAs) e organizações já tomaram a dianteira e pretendem investir no desenvolvimento das novas velocidades:

Além das iniciativas do mercado, no âmbito normativo, o grupo NEA (New Ethernet Applications) do IEEE 802.3 - o mesmo que liderou a edição do BWA Report - está considerando uma nova proposta de padrão ainda sem definição de velocidade, mas que será o “além dos 400G”. Vários desafios técnicos estão em discussão, o que vai exigir muito trabalho desse novo grupo de estudo, que pode começar em 2021.

Quanto às aplicações para a próxima velocidade, podemos considerar duas perspectivas mais amplas: o uso a partir do core da rede e as conexões intra e inter-data centers.

Maiores velocidades são adotadas sempre no centro da rede, naturalmente em função do volume de dados e da banda requerida nesse nível. Espera-se que as conexões entre equipamentos Spine e Leaf estejam preparadas para um futuro 800 Gb/s, da mesma maneira que hoje estão sendo conectados por 400 Gb/s, ou ainda com 100 Gb/s. A arquitetura mais tradicional hierárquica também deve acomodar, primeiramente, nas conexões entre os Switches Core e os Agregadores.

Esse movimento deve “empurrar” as velocidades consideradas altas, hoje no centro, mais para a borda das redes, alcançando as camadas na direção dos servidores. Em pouco tempo, os servidores serão ligados por links de 50 Gb/s e 100 Gb/s, por exemplo. Hoje é comum que velocidades de 10 Gb/s e 25 Gb/s conectem os servidores, muitas vezes ainda usando cabos de cobre.

O cenário inter-data centers está adotando rapidamente as maiores velocidades diretas, aproveitando essa característica para manter as comunicações em tempo real e atender à demanda maior por serviços em nuvem, com a sincronização necessária. A implementação 400G-ZR, publicada pelo Optical Internetworking Forum (OIF) em março de 2020, é hoje uma das mais discutidas e consideradas para as conexões de 80 a 120 quilômetros entre data centers. Nesse mesmo fórum, está em discussão o que poderá vir depois, sendo o 800G-ZR uma das opções. O caminho já está sendo aberto, uma vez que o próprio OIF iniciou estudo sobre a implementação elétrica de 224 Gb/s, que deverá ser uma base para o próximo salto.

A conclusão é que a velocidade das redes sempre irá aumentar, pois a demanda por mais banda, maior disponibilidade e acesso mais instantâneo só cresce. Se a taxa de crescimento continuará a desafiar a Lei de Moore, só o futuro dirá. A busca continua no sentido de tornar a tecnologia capaz de entregar esse aumento cada vez maior da velocidade a um custo aceitável. O data center segue sendo o ator principal nesse cenário. Nele devem ser concentrados os primeiros investimentos na próxima onda, quando, daqui a alguns anos, o 400G estiver em plena atividade.