Inteligencia artificial, almacenamiento, procesamiento, chips, cómputo, digitalización, OpenAI, NVIDIA. Ya no hace falta formar parte del ecosistema de los Data Centers para escuchar y leer noticias que hagan mención a una (o más) de estas palabras. La verdad es que en un periodo de menos de dos años hemos presenciado un auge de la inteligencia artificial, una tecnología que no solo está transformando la forma que muchas empresas operan sus negocios, sino que también trae consigo cambios en la gestión y operación de los Data Centers.

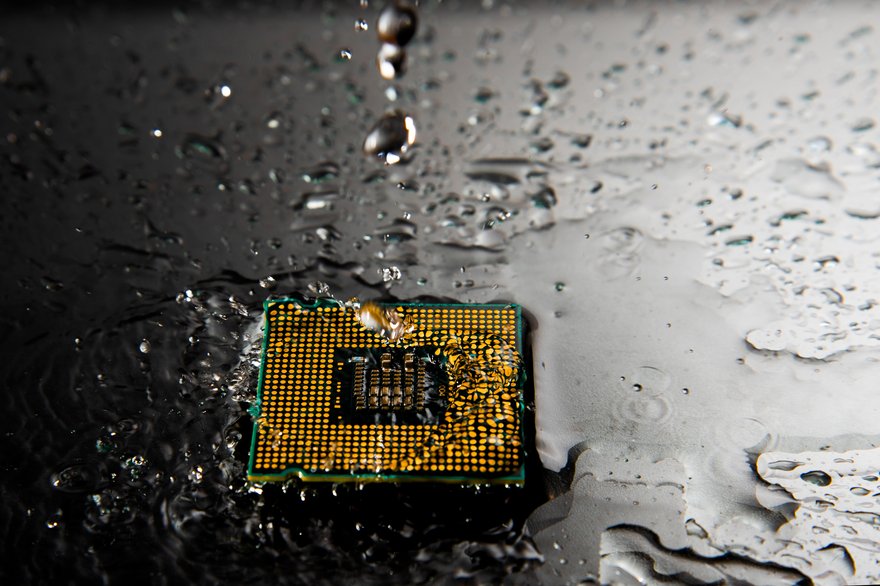

La tendencia va por un camino ya bastante conocido por la industria: mayor demanda de almacenamiento de datos y nuevas tecnologías de inteligencia artificial crean una creciente necesidad de procesamiento (razón por la cual NVIDIA se ha convertido en la joya de la corona del mundo de la tecnología) y, consecuentemente, mayor es la temperatura dentro de los Data Centers por el calor generado, de modo que los sistemas de refrigeración por aire ya no son suficientes para evitar el sobrecalentamiento y prolongar la vida útil de los sistemas informáticos.

La densidad en los Data Centers crece de manera tan acelerada que, probablemente, en tan solo un año, este texto estará desactualizado. En un sector como este, donde las inversiones en chips alcanzan la cifra de billones de dólares, la evolución y los cambios se desarrollan a velocidad de vértigo. Schneider Electric predice que las cargas de trabajo basadas en IA podrían crecer de 4,3 GW a 13,5 GW en los próximos cinco años, pasando del 8% las cargas de trabajo actuales al 15-20%.

“Anteriormente, se observaban densidades entre 2 y 5 kW por rack, sin embargo, la implementación de tecnologías como la IA y e-learning, las densidades pueden superar los 20 kW por rack e incluso llegar a los 50 kW en algunos casos avanzados”, comenta José Islas, Data Center Business Development Director en MTP, en entrevista a DatacenterDynamics.

Y aquí lanzamos una pregunta clave: ¿las inversiones y la evolución de los sistemas de cooling caminan al mismo ritmo?

¿El futuro es líquido?

Según Douglas Insights, el mercado del enfriamiento líquido crecerá a un ritmo anual del 20% hasta 2028. De manera similar, un análisis del mercado de refrigeración líquida para Data Centers, realizado por Mordor Intelligence, indica que se estima que el tamaño de este mercado sea de 4,77 mil millones de dólares en 2024, y se proyecta que alcance los 14,81 mil millones de dólares en 2029, con un crecimiento a una tasa compuesta anual del 25,44% durante el periodo previsto (2024-2029). Este aumento se debe en gran medida a la necesidad de gestionar la importante emisión de calor de los chips con un TDP elevado, como los chipsets H200 de NVIDIA, que pueden alcanzar hasta 700 W.

A medida que avanzamos hacia la nueva era de la computación acelerada y el aprendizaje automático (ML), presenciaremos un nuevo capítulo en la historia de los Data Centers, donde la infraestructura se vuelve más especializada y escalable. Esto se debe, entre otras razones, al uso de servidores de entrenamiento e inferencia de IA que emplean aceleradores y procesadores con un alto consumo de energía térmica (TDP), lo que hace que la refrigeración por aire de estos chips sea menos práctica, confiable y eficiente. La refrigeración únicamente por aire no puede mitigar de manera efectiva el sobrecalentamiento de los equipos, como señala Vertiv en uno de sus Whitepapers con DCD.

En este sentido, para soportar las cargas de trabajo de IA, un número creciente de servidores necesitará sistemas de refrigeración líquida. En comparación con la refrigeración convencional por aire, la refrigeración líquida proporciona beneficios como una mayor eficiencia energética, un menor espacio ocupado y un TCO (Costo Total de Propiedad) más bajo.

Los operadores de Data Centers, sobre todo los de colocation, también han estado innovando para adaptarse a hardwares cada vez más densos en potencia. Antes, tenían que usar diferentes niveles de potencia para acomodar distintas tecnologías de los clientes. Pero ahora, con el hardware más potente, colocar las computadoras en varios racks se vuelve complicado y caro debido al cableado extra. Por eso, usar refrigeración líquida ayuda a ahorrar espacio y a poner las computadoras potentes más cerca unas de otras. Esto aprovecha mejor el espacio y permite que las computadoras manejen cargas de trabajo pesadas como la inteligencia artificial y la computación de alto rendimiento.

Y dado que la refrigeración líquida es más eficiente en la transferencia de calor que el aire, más energía puede dedicarse a ejecutar cálculos en lugar de alimentar ventiladores. Esto aumenta efectivamente la capacidad sin necesidad de utilizar más energía o espacio. En conjunto, la refrigeración líquida puede aumentar la capacidad de cálculo de un Data Center incluso cuando las densidades continúan aumentando.

No nos podemos quedar sin aire

Aunque estamos hablando y seguiremos hablando cada vez más sobre la implementación y el desarrollo de tecnologías de enfriamiento líquido para acompañar los avances de la inteligencia artificial y disipar el calor de las operaciones densas, eso no significa que el enfriamiento por aire vaya a dejar de existir.

El enfriamiento por aire sigue siendo útil y eficiente, especialmente para los Data Centers on-premise. Según un estudio de Accenture, el 98% de los directivos empresariales afirman que la IA desempeñará un papel importante en sus estrategias en los próximos tres a cinco años, pero eso no significa que todas estas empresas vayan a aumentar el procesamiento de sus datos a niveles tan altos como para que el enfriamiento por aire se vuelva inviable. Muchas de estas empresas ni siquiera tienen sus propios Data Centers, sino que utilizan la nube - y las grandes empresas de nube, como AWS, Azure y Google, ya están construyendo instalaciones preparadas para un futuro líquido.

DCD habló con proveedores de colocation sobre sus observaciones a respecto de la demanda de densidad frente a la refrigeración líquida. Aunque la mayoría reportó un aumento en las densidades, este crecimiento es gradual. El interés predominante en refrigeración líquida sigue estando centrado en el chip mismo, y actualmente hay escasa demanda de sistemas de inmersión entre su base de clientes más extensa.

En ese sentido, los especialistas apuntan hacia implementaciones híbridas que combinen refrigeración por aire con diversas formas de refrigeración líquida como la tendencia futura en los Data Centers, a medida que aumentan las densidades y se busca un equilibrio entre eficiencia y rendimiento.

Casi el 25% de los profesionales de los Data Centers no conocen la tecnología de enfriamiento líquido

Según un estudio reciente realizado por DatacenterDynamics, que analizó las opiniones de especialistas en la industria de los Data Centers sobre el uso de sistemas de enfriamiento líquido, todavía hay una diversidad de perspectivas y percepciones sobre la viabilidad y eficiencia de esta tecnología.

El 55% de los participantes considera que estos sistemas son prometedores, pero aún requieren más investigación. Este grupo reconoce el potencial de la tecnología; sin embargo, aboga por un enfoque prudente antes de una implementación generalizada a lo largo de los próximos años.

El 21% sostiene que los sistemas de enfriamiento líquido son altamente eficientes y deberían implementarse ampliamente. Esta perspectiva subraya la confianza en la eficacia de estas tecnologías y apoya su adopción generalizada en los Data Centers. En este caso, esos profesionales consideran que la implementación masiva de sistemas de enfriamiento líquido puede ser una solución eficiente y sostenible para mejorar la eficiencia energética en estas instalaciones.

Sin embargo, aunque se hable cada vez más sobre el aumento de la densidad, el 24% de los profesionales del sector de los Data Centers indican no estar familiarizados con estos sistemas de enfriamiento y, por lo tanto, no podrían opinar sobre si serían la solución para las operaciones o no. Este dato es sumamente importante para entender que todavía hace falta una mayor conciencia sobre las tecnologías emergentes en el ámbito de los Data Centers. La falta de familiaridad por parte de los profesionales y empresas incluso puede ser un factor limitante para la adopción.

En este sentido, aunque es evidente que el panorama del enfriamiento en los Data Centers está experimentando una transformación significativa hacia soluciones de refrigeración líquida debido a la necesidad de gestionar el calor generado por los chips de alta potencia utilizados en la computación acelerada y el aprendizaje automático, la adopción de soluciones de refrigeración líquida aún enfrenta ciertas barreras, incluida la falta de familiaridad y percepciones diversas sobre su eficacia y viabilidad.

Por lo tanto, con el enfriamiento por aire siendo relevante y eficaz para muchos Data Centers, especialmente para aquellos on-premise y con cargas de trabajo menos intensivas, el futuro del enfriamiento en los Data Centers parece dirigirse hacia implementaciones híbridas que combinan ambas tecnologías, buscando un equilibrio entre eficiencia y rendimiento.

En última instancia, el camino hacia el futuro del enfriamiento en los Data Centers implicará un proceso gradual de investigación, evaluación y adopción conforme la industria avanza hacia operaciones más eficientes y sostenibles.