Los diseñadores y constructores de centros de datos deben estar al tanto de los últimos desarrollos en hardware de servidor: los entornos que crean requieren una inversión inicial masiva y se espera que duren al menos 20 años, por lo que deben estar preparados para alojar el equipo de TI del futuro.

La última tendencia en las cargas de trabajo de TI que afectará la forma en que se construyen los centros de datos es el aprendizaje automático. Las ideas que impulsan el auge de la inteligencia artificial no son nuevas, muchas de ellas fueron propuestas en la década de 1950, y el poder de la IA sin duda se exagera, pero hay muchos casos de uso en los que la tecnología de IA en su estado actual ya está trayendo beneficios tangibles.

Por ejemplo, los algoritmos son mucho mejores que las personas para proteger las redes corporativas, capaces de detectar anomalías que los humanos y sus herramientas basadas en reglas podrían pasar por alto. Los algoritmos también son excelentes para analizar grandes fragmentos de texto aburrido: los abogados usan software basado en inteligencia artificial para escanear a través de los archivos de casos y contratos, mientras que las universidades usan algo similar para establecer si el estudiante que lo envió escribió un documento o si contrató a un profesional independiente. Y, por último, hay muchas investigaciones que sugieren que el reconocimiento de imágenes ópticas igualará e incluso superará a los mejores médicos humanos para detectar signos de enfermedad en las exploraciones radiológicas.

La variedad de aplicaciones de aprendizaje automático solo va a aumentar, presentando demandas radicalmente diferentes sobre el rendimiento del almacenamiento, el ancho de banda de la red y la informática, más parecido a algo visto en el mundo de las supercomputadoras.

Es momento de un cambio

Según un reciente informe de investigación de Tractica, una firma de analistas centrada en tecnologías emergentes, las ventas de hardware de inteligencia artificial a la nube y los centros de datos empresariales verán una tasa de crecimiento anual compuesta (CAGR) de casi el 35 por ciento durante los próximos seis años, aumentando desde alrededor de 6.200 millones de dólares en 2018 a 50 mil millones para 2025. Todo este equipo tendrá mayores densidades de potencia que la TI tradicional y, como resultado, mayores requisitos de enfriamiento.

Hasta ahora, la mayoría de las tareas de aprendizaje automático se han realizado en bancos de GPU, conectados a la menor cantidad posible de placas base. Cada GPU tiene miles de núcleos pequeños que necesitan ser alimentados, y en promedio, una GPU necesitará más energía que una CPU.

Nvidia, el mayor proveedor mundial de chips gráficos, ha definido el estado actual del hardware ML con DGX-2, una caja de 10U para entrenamiento de algoritmos que contiene 16 GPU Volta V100 junto con dos CPU Intel Xeon Platinum y 30 TB de almacenamiento flash. DGX-2 ofrece hasta dos petaflops de cómputo, y consume la increíble potencia de 10kW, más de un rack completo de 42U de servidores tradicionales que se ejecutan a una carga promedio.

Hay casi dos partes en casi cualquier proyecto de aprendizaje automático: capacitación e inferencia. La inferencia es fácil, solo toma un modelo de aprendizaje automático completamente desarrollado y lo aplica a cualquier dato que desee manipular. Este proceso puede ejecutar el reconocimiento facial en un teléfono inteligente, por ejemplo. Es la capacitación la parte intensiva: lograr que la modelo mire miles de caras para aprender cómo debería ser una nariz.

"Se utilizan grandes cantidades de cómputo y la capacitación puede llevar días, semanas, a veces incluso meses, según el tamaño de la red [neural] y la diversidad de los datos que se introducen en ella y la complejidad de la tarea que estamos tratando de entrenar a la red”, dijo Bob Dletcher, vicepresidente de estrategia de Verne Global, a DCD. Verne dirige un campus de centro de datos en Islandia que originalmente se dedicó a HPC a escala industrial, pero recientemente adoptó las cargas de trabajo de IA. La compañía también ha experimentado con blockchain, pero ¿quién no ha hecho eso?

Según Fletcher, la capacitación en inteligencia artificial está demostrando ser mucho más intensiva en cómputo que las cargas de trabajo de HPC tradicionales a las que la compañía está acostumbrada, como la dinámica de fluidos computacional. “Tenemos personas como DeepL [un servicio de traducción automática] en nuestro centro de datos que ejecutan decenas de racks llenos de servidores con GPU; los están ejecutando al 95 por ciento, todo el tiempo. Suena como un motor a reacción y han estado funcionando así durante un par de años”, dijo. De lo que muchas personas no se dan cuenta es del hecho de que los modelos de aprendizaje automático utilizados en la producción tienen que volverse a entrenar y actualizar todo el tiempo para mantener la precisión, creando una necesidad sostenida de cómputo, en lugar de un pico único.

Cuando se aloja equipo de aprendizaje automático, es absolutamente necesario ser religioso sobre la contención del pasillo y cosas como placas ciegas. "Pasas de 3-5kW a alrededor de 10kW por rack para HPC normal, y si vas a cargas de trabajo de IA, que generalmente van a estar entre 15-35kW refrigeradas por aire, entonces debes tener más cuidado con el manejo del aire," explica Fletcher.

“Si miras algo como DGX-2, expulsa 11-12kW de aire caliente. Y tiene una dispersión de temperatura muy baja entre la entrada y la salida, por lo que el flujo de aire es bastante rápido. Si no piensa en el posicionamiento, y tiene dos de estos a la misma altura, apuntando hacia atrás y tal vez a 30 pulgadas entre ellos, se lanzarán aire caliente el uno al otro como locos, y perderá el flujo de aire.

"Por lo tanto, debe colocarlos a diferentes alturas, o debe usar deflectores de aire, o puede separar los pasillos, pero haga lo que haga, debe asegurarse de que todo el aire caliente que sale uno de estos dispositivos no va a golpear el aire caliente que sale de otro ".

El advenimiento del hardware de IA en el centro de datos podría finalmente marcar el momento en que el enfriamiento por agua finalmente se hace necesario. “Uno de los cambios reales desde la perspectiva del operador de un centro de datos son los chips refrigerados por agua directos para admitir algunas de estas aplicaciones. Estos productos estuvieron una vez en las hojas de ruta, y ahora son convencionales: la razón por la que están disponibles se debe a algunas de estas cargas de trabajo en torno a la IA ", dijo Paul Finch, CEO de Kao Data.

Kao acaba de abrir un campus de colocación al por mayor cerca de Londres, inspirado en diseños de hiperescala, con 8.8MW de capacidad de energía disponible en la Fase 1 y 35MW en total. El proyecto se desarrolló con la vista puesta en el futuro y, según Finch, ese futuro incluye mucha inteligencia artificial. Él dice que las salas de datos en Kao han sido diseñadas para soportar hasta 70kW por rack.

“Muchos de estos nuevos procesadores, los verdaderos Ferrari de la tecnología de chips, ahora se están enfriando con agua. Si su centro de datos no puede admitir procesadores enfriados por agua, en realidad se excluirá del extremo superior del mercado ", dijo Finch a DCD.

“En términos de la arquitectura del centro de datos, tenemos alturas de piso a techo más altas, obviamente el agua es mucho más pesada que el aire, por lo que no se trata solo del peso de TI, sino del peso del agua utilizada para enfriar Los sistemas informáticos. Todo eso debe tenerse en cuenta en la estructura del edificio y la carga del piso. Vemos el enfriamiento por inmersión como una alternativa viable, solo viene con algunos desafíos diferentes”.

Los pisos no son el componente de centro de datos más glamoroso, pero incluso los pisos deben considerarse al alojar equipos de inteligencia artificial, ya que los bastidores de alta densidad también son más pesados. Como muchos de los proyectos recientes del centro de datos, Kao aloja servidores en una losa de concreto. Esto lo hace adecuado para bastidores prepoblados de estilo hiperescala como los construidos por los fanáticos del Open Compute Project, y permite que la instalación soporte alturas de hasta 58U.

Y en términos de redes, Fletcher dijo que la IA requiere una conectividad InfiniBand más costosa entre los servidores: la Ethernet clásica simplemente no tiene suficiente ancho de banda para admitir clústeres con docenas de GPU. Los cables entre servidores en un clúster también deben mantenerse lo más cortos posible. "No solo está mirando las restricciones de enfriamiento, sino también las restricciones de conectividad y redes para mantener el rendimiento lo más alto posible", dijo.

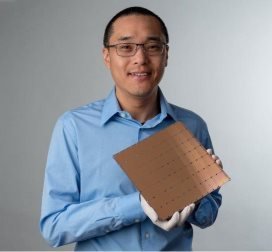

En los próximos años, el hardware para las cargas de trabajo de aprendizaje automático se volverá mucho más diverso, con todo tipo de nuevos aceleradores de IA que luchan en el mercado, todos introduciendo invariablemente sus propios acrónimos para significar una nueva clase de dispositivos: estos incluyen la inteligencia de Graphcore Unidades de procesamiento (IPU), procesadores de red neuronal Nervana de Intel (NNP) y plataformas de aceleración de cómputo adaptativo (ACAP) de Xilinx. Google tiene sus propias Unidades de Procesamiento de Tensor (TPU), pero estas solo están disponibles en la nube. La startup estadounidense Cerebras Systems presentó recientemente el Wafer Scale Engine (WSE), un solo chip que mide 8,5 por 8,5 pulgadas y cuenta con 400.000 núcleos, todos optimizados para el aprendizaje profundo.

No está del todo claro cómo este monstruo encajará en una disposición de rack estándar, pero sirve como un gran ejemplo de cuán extraño podría ser el hardware de inteligencia artificial del futuro.