En 1971, Intel, entonces fabricante de memoria de acceso aleatorio, lanzó oficialmente el 4004, su primera unidad central de procesamiento de un solo chip, iniciando así casi 50 años de dominio de la CPU en la informática.

En 1989, mientras trabajaba en el CERN, Tim Berners-Lee utilizó una computadora NeXT, diseñada alrededor de la CPU Motorola 68030, para lanzar el primer sitio web, haciendo que la máquina utilizara el primer servidor web del mundo.

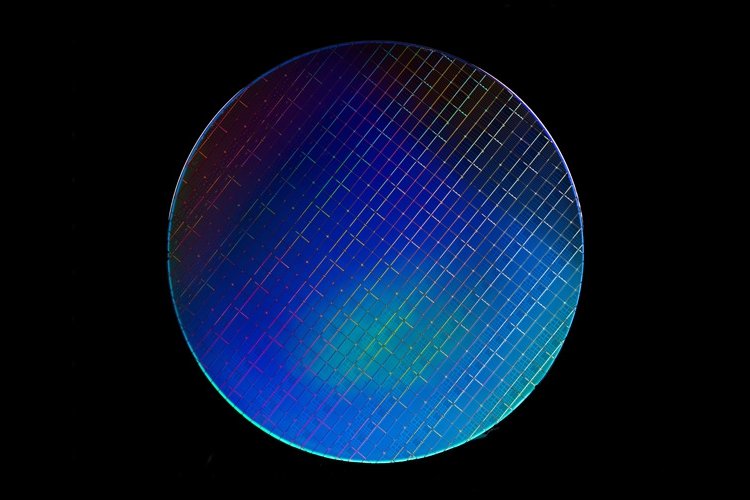

Las CPU eran las partes más caras, más avanzadas científicamente y que consumían más energía de un servidor típico: se convirtieron en los corazones palpitantes de la era digital, y los semiconductores se convirtieron en el punto de referencia para el avance de nuestra especie.

Dominación de Intel

Pocos pueden saber sobre el límite de Shannon o el principio de Landauer, pero todos saben sobre la existencia de la Ley de Moore, incluso si nunca han montado un procesador en su vida. Las CPU han entrado en la cultura popular y, hoy, Intel gobierna este mercado, con un casi monopolio respaldado por sus presupuestos masivos de I + D y amplias instalaciones de fabricación, mejor conocidas como "fabs".

Pero en los últimos dos o tres años, algo extraño ha sucedido: los centros de datos han comenzado a alojar más y más procesadores que no eran CPU.

Comenzó con la llegada de las GPU. Resultó que estos procesadores masivamente paralelos no solo eran útiles para renderizar videojuegos y extraer monedas mágicas, sino también para entrenar a las máquinas a aprender, y los fabricantes de chips aprovecharon esta nueva fuente de ingresos para ganarse la vida.

En agosto, el CEO de Nvidia, Jen-Hsun ‘Jensen’ Huang, calificó a las tecnologías de inteligencia artificial como la "fuerza más poderosa de nuestro tiempo". También promocionó ejemplos de aplicaciones empresariales que podrían tardar semanas en ejecutarse en CPU, pero solo horas en GPU.

Un puñado de diseñadores de silicio observaron el éxito de las GPU mientras volaban de los estantes y pensaron: podemos hacerlo mejor. Como Xilinx, un venerable especialista en dispositivos lógicos de programación. Abuelo del silicio personalizado, se le atribuye la invención de las primeras matrices de compuertas programables en campo (FPGA) en 1985.

Las aplicaciones para FPGA abarcan desde telecomunicaciones hasta imágenes médicas, emulación de hardware y, por supuesto, cargas de trabajo de aprendizaje automático. Pero Xilinx no estaba contento con la adopción de chips antiguos para nuevos casos de uso, como lo había hecho Nvidia, y en 2018, y anunció la plataforma de aceleración de cómputo adaptativa (ACAP), una nueva arquitectura de chips diseñada específicamente para IA.

"Los centros de datos son uno de los varios mercados que se ven afectados", dijo el CEO Victor Peng en una conferencia magistral en el reciente Foro de Desarrolladores Xilinx en Amsterdam. “Todos escuchamos sobre el hecho de que se generan zettabytes de datos cada mes, la mayoría de ellos no estructurados. Y se necesita una enorme cantidad de capacidad de procesamiento para procesar todos esos datos.

"Debido a todas estas razones, John Hennessy y Dave Patterson, dos íconos en el mundo de la informática, declararon recientemente que estábamos entrando en una nueva era dorada del desarrollo arquitectónico".

Continuó: "En pocas palabras, la arquitectura tradicional que ha llevado a la industria durante los últimos 40 a 50 años es totalmente inadecuada para el nivel de generación y procesamiento de datos que se necesita hoy en día".

"Es importante recordar que es muy, muy temprano en el desarrollo de la IA", dijo más tarde Peng a DCD. "Hay una sensación creciente de que las redes neuronales profundas y convolucionales no son el enfoque correcto. Todo esto de la caja negra, donde no sabes lo que está sucediendo y puedes obtener resultados tremendamente incorrectos, es un poco desconcertante para la gente".

Un nuevo enfoque

Salil Raje, jefe del grupo de centros de datos Xilinx, advirtió: "Si está apostando por hardware y software antiguo, tendrá ciclos desperdiciados. Desea utilizar nuestra adaptabilidad y asignar sus requisitos ahora mismo, y luego la longevidad. Cuando estás haciendo ASIC, estás haciendo una gran apuesta”.

Otra compañía que está haciendo olas es el diseñador de chips británico Graphcore, que se está convirtiendo rápidamente en una de las nuevas empresas de hardware más emocionantes del momento.

La IPU GC2 de Graphcore tiene el conteo de transistores más alto del mundo para un dispositivo que realmente se envía a los clientes: 23.600.000.000 de ellos. Eso no es suficiente para mantenerse al día con las demandas de la Ley de Moore, pero son muchas más puertas de transistores que en la GPU V100 de Nvidia o la monstruosa CPU Epyc de 32 núcleos de AMD.

"La verdad es que la gente no sabe qué tipo de hardware necesitarán para la IA en el futuro cercano", nos dijo Nigel Toon, CEO de Graphcore, en agosto. "No es como construir chips para un desafío tecnológico maduro. Si conoce el desafío, solo tiene que diseñar mejor que otras personas.

“La carga de trabajo es muy diferente, las redes neuronales y otras estructuras de interés cambian de año en año. Por eso tenemos un grupo de investigación, es una especie de radar de larga distancia.

"Hay varios cambios tecnológicos masivos. Uno es la IA como carga de trabajo: ya no estamos escribiendo programas para decirle a una máquina qué hacer, estamos escribiendo programas que le dicen a una máquina cómo aprender, y luego la máquina aprende de los datos así que su programación se ha convertido en una especie de "meta". Incluso tenemos argumentos en toda la industria sobre la forma de representar números en las computadoras. Eso no ha sucedido desde 1980.

“El segundo cambio tecnológico es el final de la escala tradicional de silicio. Necesitamos un millón de veces más potencia de cómputo, pero no vamos a obtenerlo por la reducción del silicio. Por lo tanto, debemos poder aprender cómo ser más eficientes con el silicio, y también cómo construir muchos chips en sistemas más grandes.

"El tercer cambio tecnológico es el hecho de que la única forma de satisfacer este requisito de cómputo al final del escalado de silicio, y afortunadamente, es posible porque la carga de trabajo expone mucho paralelismo, es construir computadoras masivamente paralelas".

Toon no es nada sino ambicioso: espera crecer "un par de miles de empleados" en los próximos años y llevar la lucha a las GPU y su progenitor.

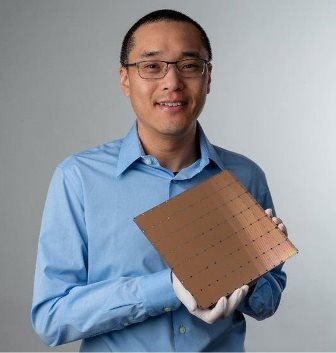

Luego está Cerebras, la nueva empresa estadounidense que sorprendió a todos en agosto al anunciar un chip gigantesco que medía casi 8,5 por 8,5 pulgadas y presentaba 400.000 núcleos, todos optimizados para el aprendizaje profundo, acompañados de una enorme memoria de 18 GB en el chip.

"El aprendizaje profundo tiene requisitos computacionales únicos, masivos y crecientes que no coinciden con máquinas heredadas como GPU, que fueron diseñadas fundamentalmente para otro trabajo", dijo el Dr. Andy Hock, director de Cerebras.

Huawei, como siempre, sigue su propio camino: el proveedor chino en problemas ha estado produciendo chips patentados durante años a través de su subsidiaria HiSilicon, originalmente para su amplia gama de equipos de red, más recientemente para sus teléfonos inteligentes.

Para su próximo truco, Huawei está interrumpiendo el mercado de hardware de inteligencia artificial con la línea Ascend, que incluye todo, desde dispositivos de inferencia pequeños hasta Ascend 910, que según afirma es el procesador de inteligencia artificial más poderoso del mundo. Agregue un montón de estos juntos, y obtendrá el Atlas 900, el grupo de entrenamiento de IA más rápido del mundo, actualmente utilizado por investigadores de astronomía chinos.

Y, por supuesto, la lista no estaría completa sin Nervana de Intel, la llegada algo tardía a la escena de la IA. Al igual que Xilinx y Graphcore, Nervana cree que las cargas de trabajo de IA del futuro requerirán chips especializados, desarrollados desde cero para admitir el aprendizaje automático, y no solo chips estándar adoptados para este propósito.

"La IA es muy nueva y naciente, y seguirá cambiando", dijo Salil Raje de Xilinx a DCD.

“El mercado va a cambiar, la tecnología, la innovación, la investigación: todo lo que se necesita es un estudiante de doctorado, para revolucionar completamente el campo nuevamente, y luego todos estos chips se vuelven inútiles. Estamos esperando ese trabajo de investigación”.