En los últimos años, Google ha estado revisando silenciosamente sus centros de datos, reemplazando su infraestructura de red con un enfoque interno radical que ha sido durante mucho tiempo el sueño de aquellos en la comunidad de redes.

Se llama Misión Apolo y se trata de usar luz en lugar de electrones y reemplazar los interruptores de red tradicionales con interruptores de circuito óptico (OCS). Amin Vahdat, líder del equipo de infraestructura de servicios y sistemas de Google, nos explicó por qué es tan importante.

Manteniendo las cosas ligeras

Hay un desafío fundamental con la comunicación del centro de datos, una ineficiencia derivada del hecho de que abarca dos mundos. El procesamiento se realiza en la electrónica, por lo que la información a nivel del servidor se mantiene en el dominio eléctrico. Pero mover la información es más rápido y más fácil en el mundo de la luz, con la óptica.

En las topologías de red tradicionales, las señales saltan de un lado a otro entre lo eléctrico y lo óptico. “Todo ha sido salto por salto, vuelves a convertir a la electrónica, la vuelves a llevar a la óptica, y así sucesivamente, dejando la mayor parte del trabajo en el dominio electrónico”, dijo Vahdat. “Esto es costoso, tanto en términos de costo como de energía”.

Con OCS, la empresa "deja los datos en el dominio óptico el mayor tiempo posible", utilizando pequeños espejos para redirigir los haces de luz desde un punto de origen y enviarlos directamente al puerto de destino como una conexión cruzada óptica.

Arrancando la columna vertebral

“Hacer que esto funcione reduce la latencia de la comunicación, porque ahora no tiene que moverse tanto por el centro de datos”, dijo Vahdat. "Elimina las etapas de la conmutación eléctrica: esta sería la columna vertebral de los centros de datos de la mayoría de las personas, incluido el nuestro anteriormente".

La arquitectura 'Clos' tradicional que se encuentra en otros centros de datos se basa en una columna vertebral hecha con conmutadores de paquetes electrónicos (EPS), construidos alrededor de silicio de compañías como Broadcom y Marvell, que está conectado a 'hojas' o conmutadores en la parte superior del bastidor.

Los sistemas EPS son costosos y consumen bastante energía, y requieren un procesamiento por paquete de alta latencia cuando las señales están en forma electrónica, antes de volver a convertirlas en forma ligera para su transmisión posterior.

OCS necesita menos energía, dice Vahdal: “Con estos sistemas, esencialmente la única energía consumida por estos dispositivos es la energía requerida para mantener los espejos en su lugar. Lo cual es una pequeña cantidad, ya que estos son pequeños espejos”.

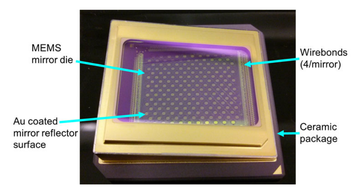

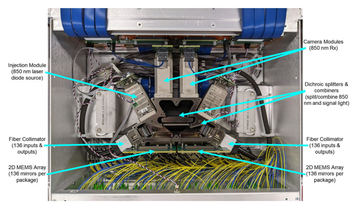

La luz ingresa al interruptor del Proyecto Apolo a través de un haz de fibras y se refleja en múltiples obleas de silicio, cada una de las cuales contiene una pequeña serie de espejos. Estos espejos son sistemas microelectromecánicos (MEMS) 3D que se pueden realinear individualmente rápidamente para que cada señal de luz se pueda redirigir inmediatamente a una fibra diferente en el paquete de salida.

Cada matriz contiene 176 espejos minúsculos, aunque solo se utilizan 136 por razones de rendimiento. “Estos espejos, son todos personalizados, todos son un poco diferentes. Y entonces, lo que esto significa es que, en todas las entradas y salidas posibles, la combinación es 136 al cuadrado”, dijo.

Eso significa 18.496 combinaciones posibles entre dos paquetes de espejos.

El consumo máximo de energía de todo el sistema es de 108 W (y generalmente usa mucho menos), que está muy por debajo de lo que puede lograr un EPS similar, alrededor de 3000 vatios.

En los últimos años, Google ha implementado miles de estos sistemas OCS. La generación actual, Palomar, "está ampliamente implementada en todas nuestras infraestructuras", dijo Vahdat.

Google cree que este es el uso más grande de OCS en el mundo, por un margen cómodo. "Llevamos en esto durante algún un tiempo”, dice Vahdat.

Constrúyelo tú mismo

El desarrollo del sistema general requirió una serie de componentes personalizados, así como equipos de fabricación personalizados.

Producir Palomar OCS significó desarrollar probadores personalizados, alineación y estaciones de ensamblaje para los espejos MEMS, los colimadores de fibra, el núcleo óptico y sus componentes constituyentes, y el producto OCS completo. Se desarrolló una herramienta de alineación automatizada y personalizada para colocar cada conjunto de lentes 2D hacia abajo con precisión submicrónica.

“También construimos los transceptores y los circuladores”, dijo Vahdat, el último de los cuales ayuda a que la luz viaje en una dirección a través de diferentes puertos. “¿Inventamos los circuladores? No, pero ¿es un componente personalizado que diseñamos, construimos e implementamos a escala? Sí."

"Hay una tecnología realmente genial en torno a estos circuladores ópticos que nos permite reducir nuestro número de fibras por un factor de dos en relación con cualquier técnica anterior", agregó.

En cuanto a los transceptores, utilizados para transmitir y recibir señales ópticas en el centro de datos, Google codiseñó transceptores de multiplexación por división de longitud de onda de bajo costo en cuatro generaciones de velocidades de interconexión óptica (40, 100, 200, 400 GbE) con una combinación de desarrollo de tecnología de procesamiento de señal, electrónica y óptica de alta velocidad.

“Inventamos los transceptores con las características correctas de potencia y pérdida, porque uno de los desafíos con esta tecnología es que ahora introducimos la pérdida de inserción en la ruta entre dos interruptores eléctricos”.

En lugar de una ruta de fibra, ahora hay interruptores de circuitos ópticos que hacen que la luz pierda parte de su intensidad a medida que rebota a través de la instalación. "Tuvimos que diseñar transceptores que pudieran equilibrar los costos, la potencia y los requisitos de formato para asegurarnos de que pudieran manejar una pérdida de inserción modesta", dijo Vahdat.

"Creemos que tenemos algunos de los transceptores con mayor eficiencia energética que existen. Y realmente nos empujó a asegurarnos de que pudiéramos diseñar cosas de principio a fin para aprovechar esta tecnología".

Parte de esa visión cohesiva es una capa de red definida por software (SDN), llamada Orion. Es anterior a la Misión Apolo, "por lo que ya nos habíamos mudado a un plano de control lógicamente centralizado", dijo Vahdat.

"El delta que pasa de un enrutamiento lógicamente centralizado en una topología basada en la columna vertebral a uno que administra esta topología de conexión directa con cierta cantidad de ingeniería de tráfico. No digo que fuera fácil, llevó mucho tiempo y muchos ingenieros, pero no fue un gran salto, como hubiera sido si no hubiéramos tenido la ingeniería de tráfico SDN antes".

La compañía "esencialmente amplió Orion y su plano de control de enrutamiento para administrar estas topologías de conexión directa y realizar ingeniería de tráfico y reconfiguración de los espejos al final, pero topología lógica en tiempo real basada en señales de tráfico.

"Por lo tanto, fue una empresa sustancial, pero era imaginable, en lugar de inimaginable".

Patrones de detección

Uno de los retos de Apolo es la reconfiguración del tiempo. Mientras que las redes Clos usan EPS para conectar todos los puertos entre sí a través de sistemas EPS, OCS no es tan flexible. Si desea cambiar su arquitectura de conexión directa para conectar dos puntos diferentes, los espejos tardan unos segundos en reconfigurarse, lo que es significativamente más lento que si se hubiera quedado con EPS.

El truco para superar esto, cree Google, es reconfigurar con menos frecuencia. La empresa implementó su infraestructura de centro de datos junto con el OCS, construyéndolo con el sistema en mente.

"Si agrega suficientes datos, puede aprovechar los patrones de comunicación de larga duración", dijo Vahdat. "Usaré la terminología de Google 'Superblock', que es una agregación de 1-2000 servidores. Hay una cantidad estable de datos que van a otro Superblock.

“Si tengo 20, 30, 40 superbloques, en un centro de datos, podría ser más, la cantidad de datos que van del Superbloque X al Superbloque Y en relación con los demás no está perfectamente fijada, pero hay cierta estabilidad allí.

"Y entonces podemos dejar las cosas en el dominio óptico y cambiar esos datos al Superbloque de destino, dejándolo todo óptico. Si hay cambios en los patrones de comunicación, ciertamente cambios radicales, entonces podemos reconfigurar la topología".

Eso también crea oportunidades para reconfigurar redes dentro de un centro de datos. “Si necesitamos más conmutadores de paquetes eléctricos, esencialmente podemos reclutar dinámicamente un Superblock para que actúe como una columna vertebral”, dijo Vahdat.

“Imagínese que tenemos un Superbloque sin servidores conectados, ahora puede reclutar ese Superbloque para que actúe esencialmente como una columna vertebral dedicada”, dijo, y el sistema se hizo cargo de un bloque que aún no tiene servidores o no lo está. en uso.

“No necesita sincronizar ningún dato, puede transferir datos hacia adelante. Una supermanzana que no es una fuente de tráfico puede convertirse esencialmente en una mini-columna vertebral. Si te encanta la teoría de grafos y te encanta el enrutamiento, es un resultado realmente genial. Y resulta que me encanta la teoría de grafos."

Siempre en línea

Otra cosa que le encanta a Vahdat y a Google en general es lo que eso significa para el tiempo de operación.

“Los interruptores de circuitos ópticos ahora pueden convertirse en parte de la infraestructura del edificio”, dijo. “A los fotones no les importa cómo se codifican los datos, por lo que pueden pasar de 10 gigabits por segundo a 40, a 200, a 400 a 800 y más allá, sin necesidad de actualizarse necesariamente".

Diferentes generaciones de transceptores pueden operar en la misma red, mientras que Google actualiza a su propio ritmo, “en lugar del estado del arte externo, que básicamente decía que una vez que pasas de una generación de velocidades a otra, tienes que quitar todo del centro de datos y empezar de nuevo”, dijo Vahdat.

“La parte más dolorosa desde la perspectiva de nuestros clientes es que está fuera por seis meses y tienen que migrar su servicio por un período prolongado”, dijo.

“A nuestra escala, esto significaría que siempre estamos empujando a la gente hacia adentro y hacia afuera, porque tenemos que actualizar algo en algún lugar en todo momento, y nuestros servicios se implementan en todo el planeta, con múltiples instancias, eso significa que nuevamente, nuestro los servicios estarían sujetos a estos movimientos todo el tiempo”.

Del mismo modo, ha reducido los costos de capex ya que se puede usar el mismo OCS en cada generación, mientras que los sistemas EPS deben reemplazarse junto con los transceptores. La compañía cree que los costos se han reducido hasta en un 70 por ciento. “Los ahorros de energía también fueron sustanciales”, dijo Vahdat.

Mantener esa comunicación en forma ligera está configurado para ahorrar miles de millones a Google, reducir su uso de energía y reducir la latencia.

Qué viene ahora

“Lo estamos haciendo a nivel de supermanzana”, dijo Vahdat. “¿Podemos averiguar cómo haremos una reconfiguración óptica más frecuente para que podamos empujarlo aún más hacia el nivel superior del rack, porque eso también tendría algunos beneficios sustanciales? Ese es un problema difícil que no hemos resuelto por completo”.

La empresa ahora busca desarrollar sistemas OCS con mayor número de puertos, menor pérdida de inserción y tiempos de reconfiguración más rápidos. "Creo que las oportunidades de eficiencia y confiabilidad aumentan a partir de ahí", dijo Vahdat.

El impacto puede ser enorme, anotó. “El ancho de banda de bisección de los centros de datos modernos hoy en día es comparable a Internet en su conjunto”, dijo.

“En otras palabras, si toma un centro de datos (no me refiero solo al nuestro, esto sería lo mismo en su centro de datos [hiperescala] favorito) y lo corta a la mitad y mide la cantidad de ancho de banda que atraviesa las dos mitades, es tanto ancho de banda como verías si redujeras Internet a la mitad. Así que es una enorme cantidad de comunicación”.