Seguramente, en uno de nuestros contenidos o a lo largo de tu trayectoria profesional, habrás comprendido que, en la era digital, los data centers son imprescindibles para la conectividad global, garantizando servicios esenciales y de entretenimiento que influyen en nuestra vida diaria. No es coincidencia que la eficiencia y confiabilidad de estos centros sean fundamentales para mantener la continuidad del mundo tal como lo conocemos. En este contexto, dos elementos clave destacan por su contribución esencial al rendimiento óptimo y la operatividad constante de estas infraestructuras críticas: los sistemas de energía y de enfriamiento.

En este artículo, exploramos estos dos aspectos interrelacionados al abordar información que quizás ya conozcas, pero enriqueciéndola con datos actuales. Después de todo, ya sea para pequeños o grandes data centers, incluyendo los hyperscales, la gestión eficiente de la energía y de la refrigeración constituye la piedra angular de toda la operación.

Gestión de energía

Comencemos hablando sobre la importancia de gestionar la energía en los data centers, una acción (o más bien un conjunto de acciones) necesaria para, en primer lugar, mantener el funcionamiento continuo y, en segundo lugar, evitar fallos graves.

Lo más importante cuando hablamos de gestión de energía es entender que no solo se trata de una lista de consideraciones técnicas, sino también de una estrategia para optimizar los costos operativos de un data center. Con el aumento de la densidad en los racks y la creciente adopción de la inteligencia artificial, pensar en la gestión energética de manera más integral se vuelve crucial.

Según apuntan los especialistas, los operadores deben invertir en sistemas avanzados para optimizar la entrega de electricidad a diferentes componentes, siendo capaces de evaluar y reportar la eficiencia de esta distribución mediante parámetros específicos, como el factor de potencia y la pérdida de energía durante la transmisión. Además, la gestión de la energía también debe pasar por los sistemas de respaldo, como UPS y generadores, esenciales para garantizar la continuidad operativa en casos de cortes de energía. Crear estrategias para mejorar esta parte de la infraestructura no solo asegura un suministro ininterrumpido, sino que también prepara las instalaciones para un escenario de escalabilidad y alta demanda energética, asociada al rápido desarrollo de los data centers.

Otro factor a considerar es el clima, especialmente en un contexto de cambios climáticos y episodios de olas de calor. Estos eventos extremos ponen a prueba la red eléctrica, por lo que invertir en equipos modernos se presenta como una estrategia clave para proteger la integridad de los sistemas de energía en los próximos años. En los últimos DCD>Connects (Madrid, Cancún y São Paulo), se ha demostrado que muchos sistemas UPS actuales tienen modos de funcionamiento ecológicos de alta eficiencia. Estos modos pueden reducir significativamente la cantidad de energía extraída de la red. En entornos cambiantes, cualquier reducción en la demanda puede marcar la diferencia entre un servicio ininterrumpido y un corte de energía devastador.

Otras consideraciones a tener en cuenta

La eficiencia en la gestión de energía de un data center también tiene un impacto directo en su huella ambiental. Mejorar la distribución de energía y utilizar sistemas eficientes posibilita la reducción de las emisiones de carbono asociadas.

Sin embargo, la sostenibilidad aún no figura entre las principales preocupaciones de los operadores, según Gabriel di Lorenzo Méndez, Director en Tecno Diar e instructor en DCD>Academy. De acuerdo con el experto, al tomar decisiones, los propietarios de colocation, data centers empresariales o de edge tienden a enfocarse más en la disponibilidad que en los costos o la sostenibilidad.

“Distinto es el caso de los propietarios de data center de hiperescala, dedicados básicamente a brindar servicios de cloud, donde existe un enfoque agresivo para la reducción de costos operativos”, señala di Lorenzo.

"Aquellos propietarios que confían en su infraestructura y superan los desafíos de disponibilidad comienzan a integrar sistemas de energías renovables, como paneles solares o turbinas eólica". Según el especialista, "en ocasiones, los temas de sustentabilidad lo tratan en un segundo plano como consecuencia de la reducción del OPEX ".

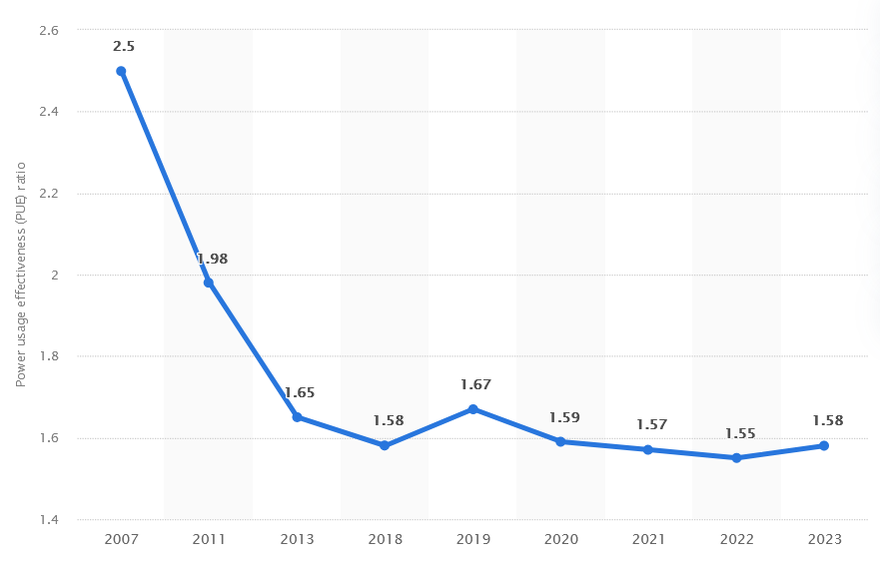

Medición y pérdidas

No podemos abordar el tema de la energía sin tener en cuenta la medición del consumo, un factor esencial para evaluar la eficiencia de un data center. El Índice de Efectividad del Uso de Energía (PUE) es la métrica clave, calculada al dividir el consumo total de electricidad entre la electricidad suministrada a la infraestructura informática. Según una encuesta global de data centers del Uptime Institute, el promedio del PUE en la industria en 2023 fue de 1,58.

Aunque el número es positivo, al compararlo con una década atrás, las pérdidas de energía persisten como un desafío significativo, representando aproximadamente el 10% del consumo total en un data center. Estas pérdidas no solo afectan la eficiencia operativa, sino que también contribuyen considerablemente a la factura de electricidad. Especialistas en el tema indican que la implementación de soluciones innovadoras, como relés de enclavamiento en PDU inteligentes, transformadores y UPS de alta eficiencia, puede contribuir a la reducción de estas pérdidas e incluso ayudar en la disminución de la huella medioambiental de los data centers.

A enfriar un poco

En los equipos informáticos, prácticamente toda la energía consumida se transforma en calor. Así, el enfriamiento se posiciona como el segundo componente crítico en la infraestructura de los Data Centers, especialmente a medida que la densidad aumenta, generando mayores demandas en la gestión térmica.

"Cuanto más procesamiento, más calor. Si en 2011 teníamos una media de 2,4 kW/rack en los data centers, actualmente tenemos más de 8 kW/rack. Como resultado, hemos experimentado una importante evolución en las estrategias sobre cómo eliminar este calor de los data centers”, comenta Alexandre Kontoyanis, Presidente de ASHRAE Brasil Chapter.

"La mayoría de los data centers actuales todavía utilizan la refrigeración por aire como estrategia principal y esta estrategia sigue siendo muy funcional para racks de hasta 10 kW o 15 kW. Sin embargo, al superar esta potencia, será necesario adoptar otro tipo de estrategia para combatir este calentamiento. Actualmente, hay aplicaciones que llegan a los 100 kW por rack y eliminar este calor a través del aire se vuelve inviable. Para estas aplicaciones de alta densidad, se utilizan estrategias de refrigeración líquida. Esta técnica se ha desarrollado rápidamente y hoy contamos con aplicaciones que funcionan completamente sumergidas en un líquido dieléctrico. Además, estos fluidos pueden trabajar a temperaturas más elevadas (algunos hasta 70 °C), lo que hace muy atractivo reutilizar este calor, además de la facilidad de utilizar solo la temperatura ambiente exterior para reducir la temperatura de este líquido, es decir, sin el uso de compresores y con bajo consumo energético”, complementa.

La prevención del sobrecalentamiento y la garantía de un entorno operativo óptimo para equipos sensibles son responsabilidades esenciales de los sistemas de refrigeración. Para abordar este desafío, la implementación de métodos tradicionales, como la refrigeración por aire, se combina con enfoques innovadores, incluido el free cooling y sistemas de refrigeración de precisión basados en líquido, con el objetivo de maximizar la eficiencia térmica.

Según el consultor especializado en refrigeración, Rolf Brink, en los próximos años veremos más entornos híbridos donde la infraestructura y las instalaciones subyacentes puedan atender tanto a la refrigeración por aire como a la refrigeración líquida. "La industria necesita prepararse", afirma.

Amet Novillo, Director General de Equinix México, destaca que "debido a que el sistema de enfriamiento en sí puede representar más del 35% del consumo de energía eléctrica en el centro de datos (según el sistema utilizado), la elección adecuada del sistema de enfriamiento se vuelve un factor sumamente importante".

"Ahora bien, desafortunadamente, no existe una solución universal. Podríamos considerar que un sistema de free cooling es la solución para todos los data centers, pero no en todas partes tendría el mismo rendimiento o incluso la posibilidad de operar. Un sistema adiabático se vería limitado por las condiciones de temperatura y humedad exteriores, así como por la disponibilidad de agua. Un sistema de enfriamiento mecánico enfriado por agua es más eficiente que uno enfriado por aire; pero, en lugares donde el agua es escasa o el costo de operación lo haga inviable, no sería una solución. Por lo tanto, la elección del sistema óptimo para cada zona será diferente debido a todos los factores a considerar. Lo que sí se puede tener en cuenta es que una vez seleccionada la solución basada en las condiciones de la zona y los recursos disponibles, se deben elegir equipos con mayor eficiencia para mantener un bajo consumo y reducir el impacto en los recursos de la zona", ejemplifica el ejecutivo.

Recientemente, la preocupación por la eficiencia de los sistemas de enfriamiento de los data centers adquirió mayor relevancia a la luz del Compromiso de Refrigeración, firmado por 63 naciones durante la COP28. Este compromiso busca reducir las emisiones provenientes de la refrigeración en dos tercios antes de 2033, comprometiendo a las naciones a lograr una disminución del 68% en las emisiones y mejorar la eficiencia energética de los sistemas de refrigeración.

La industria de los Data Centers, siendo un usuario importante de sistemas de aire acondicionado, se encuentra bajo presión adicional, considerando la creciente demanda de refrigeración debido al aumento de las temperaturas globales y, como mencionamos anteriormente, el rápido crecimiento en la densidad en los racks.

En este contexto, la adopción de medidas optimizadas de enfriamiento no solo se puede apreciar como una necesidad operativa, sino también como una contribución significativa a la reducción de las emisiones y al cumplimiento de compromisos ambientales a nivel mundial.

Un futuro líquido y sostenible

Según el Director General de cliAtec 360º Data Center, Saúl Varela, desde hace años estamos en transición hacia un nuevo estándar de refrigeración, precisamente debido a los desafíos a los que nos enfrentamos: la mayor potencia de cómputo y almacenamiento y la generación de calor. “Intel y otros fabricantes de chips pueden ofrecer procesadores más rápidos y potentes; sin embargo, requieren de 250 a 500 vatios para la eliminación de calor”. En este sentido, “la presión por reducir la huella de carbono de estas infraestructuras críticas impulsa a los data centers a buscar una nueva tecnología de enfriamiento, lo cual incluye, entre otros factores, la reducción del consumo de energía eléctrica y agua”. Las soluciones no solo deben ser líquidas, sino también sostenibles.

En un paso significativo hacia la sostenibilidad, Amazon Web Services (AWS) anunció en 2023 que 20 de sus data centers están adoptando un enfoque innovador. Estos centros utilizan aguas residuales purificadas en lugar de agua potable para sus sistemas de enfriamiento.

Además, AWS estableció metas ambiciosas y aspira a ser positiva en materia de agua hasta el año 2030, un compromiso también adoptado por Meta. La propietaria de Facebook planea tener un balance positivo en materia de agua para 2030, devolviendo al medio ambiente más agua de la que consume en sus operaciones globales. Estos dos ejemplos reflejan la importancia creciente que las empresas líderes están dando a la gestión sostenible de recursos, reconociendo la necesidad de minimizar el impacto ambiental de las operaciones de sus data centers.

Redundancia en los sistemas de climatización

En entornos críticos como los data centers, donde el control preciso de la temperatura y la humedad es fundamental, la redundancia en el sistema de climatización es otra estrategia clave para garantizar un funcionamiento ininterrumpido y una protección robusta de la infraestructura tecnológica.

En líneas generales, la redundancia implica la integración de componentes duplicados o sistemas alternativos que pueden asumir la carga en caso de una eventual falla en alguna parte del sistema de climatización. Esto se traduce en una mayor fiabilidad y capacidad de recuperación del data center frente a posibles interrupciones.

Actualmente, existen diferentes niveles de redundancia en los sistemas de climatización, desde la duplicación de unidades de enfriamiento hasta la implementación de sistemas independientes que pueden asumir la carga total en caso de un fallo grave. Además, se pueden utilizar sistemas de monitoreo avanzados para detectar problemas antes de que afecten el rendimiento y activar automáticamente los componentes redundantes.

Formación especializada

Entender las características técnicas y los avances de los sistemas de power y cooling es fundamental para la operación de los data centers. Sin embargo, estos temas no son parte de una carrera universitaria y tampoco pueden ser aprendidos mediante el método de "intento y error", ya que cualquier error implica pérdidas sustanciales de recursos y, en algunos casos, dañan directamente la imagen corporativa de la empresa. Así, la capacitación de profesionales en los sistemas de power y cooling no solo resulta ventajosa, sino que se ha vuelto imprescindible. La complejidad y la estrecha interconexión de estos sistemas demandan un conocimiento profundo y continuamente actualizado.

Desde ingenieros de consultoría hasta operadores de data centers, es esencial que posean habilidades especializadas para entender y abordar los desafíos relacionados con la energía y el enfriamiento en las operaciones.

¿Qué habilidades tiene que tener un profesional de Power & Cooling?

Se sabe que la industria de los data centers está experimentando una falta de profesionales calificados y no es casualidad. Según Alexandre Kontoyanis, Presidente de ASHRAE Brasil Chapter, “además de ser poco conocida por muchos de los profesionales, la industria exige un conjunto muy importante de hard skills y soft skills”.

Algunos de los requisitos son:

- Título en Ingeniería Eléctrica, Mecánica o Industrial (dependiendo de su rol);

- Formación específica de los equipamientos de power o cooling que se deban operar y mantener;

- Certificaciones internacionales;

- Formación en el uso de herramientas de administración de mantenimiento, como, por ejemplo, Maintenance Management Systems (MMS);

- Experiencia laboral en las áreas de mantenimiento y/o sistemas de automatización (monitoreo y control de equipos de infraestructura).

“Definitivamente, para la industria de los data centers no basta con ser un gran ingeniero mecánico o ingeniero eléctrico. Debe tener buenos conocimientos en todas las áreas y habilidades para afrontar la presión del día a día”, comenta Kontoyanis.

Las soft skills más buscadas son estas:

- Trabajo en equipo;

- Visión holística;

- Agilidad;

- Resiliencia;

- Pensamiento crítico;

- Resolución de problemas.

Capacitación y credenciales reconocidas globalmente

Según Saúl Varela, Director General en cliAtec, “los perfiles encargados de operar y mantener sistemas de power y cooling deben poseer habilidades técnicas, pero también un pensamiento innovador, dinamismo y una visión holística de las infraestructuras críticas”. De esta manera, es imperativo que las empresas promuevan iniciativas internas para desarrollar y estimular las habilidades de sus empleados, garantizando así un conjunto de competencias equilibrado y alineado con las demandas de la organización.

Además de las iniciativas internas que estimulan el desarrollo de skills, la inversión en la formación técnica de los profesionales "habilita a estos para tomar decisiones informadas y estratégicas, optimizando de esta manera el rendimiento y la longevidad de la infraestructura digital", según Víctor Segura, Director LATAM en DCD>Academy.

En este contexto, los cursos especializados, como los que ofrece DCD>Academy, desempeñan un papel crucial al proporcionar conocimientos actualizados y prácticos respaldados por certificaciones reconocidas. Esto permite a los profesionales adquirir las habilidades necesarias para enfrentar con éxito los desafíos en constante evolución de los data centers.

DCD>Academy: Power Professional

Administrar los requisitos de energía en los data centers modernos es una tarea compleja y subestimada. Estos centros operan en sus límites de diseño, y cualquier interrupción no es una opción. El curso de Power Professional de DCD>Academy aborda de manera integral los desafíos relacionados con la potencia en la infraestructura de los data centers. Desde la distribución de energía hasta la eficiencia, los participantes adquieren una comprensión detallada.

Este curso, respaldado por organizaciones reconocidas como Amazon, Microsoft, CBRE, Kyndryl, Equinix y NTT Group, se dirige a ingenieros de consultoría, ingenieros de infraestructura crítica, profesionales de ventas e ingenieros de producto de proveedores de tecnología. El examen y el certificado ofrecen una validación formal de las habilidades adquiridas, y las unidades de Desarrollo Profesional Continuo (CPD) pueden utilizarse para cumplir con requisitos corporativos y membresías profesionales.

¡Para obtener más información, acceda a la página oficial del curso PPRO!

DCD>Academy: Cooling Professional

El curso Cooling Professional, diseñado por el Prof. Robert Tozer, experto global en refrigeración, explora en detalle los conceptos clave, prácticas e interdependencias asociadas con la climatización de data centers. Desde sistemas de refrigeración hasta tecnologías emergentes, el curso adopta un enfoque práctico e interactivo para mejorar el conocimiento y la capacidad de toma de decisiones.

Al igual que el curso Power Professional, este programa cuenta con el respaldo de destacadas organizaciones y se dirige a ingenieros de consultoría, ingenieros de infraestructura crítica, así como a profesionales de ventas e ingenieros de producto.

El contenido del curso aborda temas clave como la transferencia de calor, free cooling, los sistemas de refrigeración de fluido, la gestión del aire y sistemas de control, así como recomendaciones de eficiencia energética.

¡Para obtener más información, acceda a Cooling Professional!