La empresa de chips AMD ha presentado un nuevo acelerador Instinct, el MI325X.

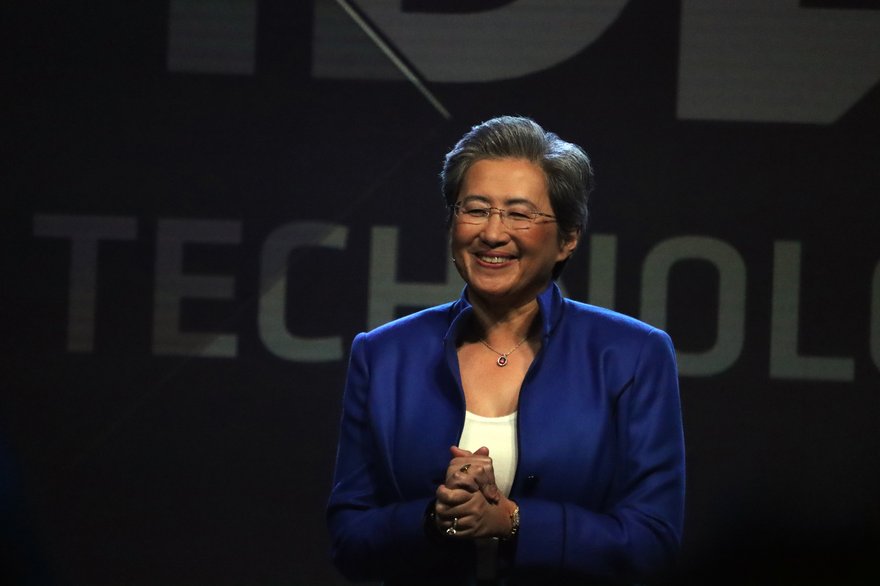

Anunciado por la directora ejecutiva de la compañía, Lisa Su, en el evento Computex de este año en Taipei, Taiwán, se espera que el acelerador AMD Instinct MI325X esté disponible para los clientes a partir del cuarto trimestre de 2024.

Con 288 GB de memoria HBM3E y un ancho de banda de memoria máximo de 6 TB/s, ocho aceleradores encajarán en la plataforma Instinct MI325X, que está construida con la misma arquitectura que la plataforma de servidor MI300X.

"MI325X amplía nuestro liderazgo en IA generativa", dijo Su durante su discurso de apertura en Computex, y agregó que un servidor avanzado que ejecuta ocho aceleradores MI325X puede ejecutar modelos avanzados de hasta 1 billón, lo que, según ella, es el doble del tamaño admitido por un servidor H200.

AMD dijo que en comparación con “la competencia” (nuevamente, las GPU de Nvidia), el MI325X cuenta con una capacidad de memoria 2 veces mayor, un ancho de banda 1,3 veces mayor y un rendimiento informático de IA 1,3 veces mejor.

En letra pequeña, AMD afirma que esta métrica se alcanzó comparando las especificaciones proyectadas del acelerador MI325X, que se espera que tenga 288 GB de capacidad de memoria HBM3e y 1,3 petaflops de FP16 y 2,6 petaflops de rendimiento informático máximo de FP8, con una selección de GPU Nvidia.

AMD dijo que los resultados más altos publicados para Nvidia Hopper H200 141GB, Blackwell HGX B100 192GB y Blackwell HGX B200 192GB demuestran una menor capacidad de memoria y rendimiento de ancho de banda que el MI325X.

El MI325X se ejecutará en la arquitectura CDNA 3 de la empresa, que ha sido diseñada específicamente para aplicaciones de centros de datos.

AMD actualiza su hoja de ruta de GPU para centros de datos

Además de anunciar el MI325X, Su también utilizó su discurso de apertura de Computex para mostrar la hoja de ruta actualizada de AMD, en la que la compañía lanzará una nueva GPU para el centro de datos cada año, comenzando con el MI325X.

"Ahora hemos ampliado nuestra hoja de ruta de productos para que tenga una cadencia anual, lo que significa un nuevo producto cada año", dijo Su durante el evento.

La compañía también presentó su arquitectura entrante CDNA 4 que se lanzará en 2025, que se utilizará para alimentar los aceleradores de la serie AMD Instinct MI350 y ofrecerá un aumento de hasta 35 veces en el rendimiento de inferencia de IA en comparación con CDNA 3.

Su lanzamiento está previsto para 2025, el acelerador AMD Instinct MI350x será el primer producto en utilizar esta nueva arquitectura. El MI350x, que contiene 288 GB de HBM3e, se fabricará mediante un proceso de 3 nm y admitirá los tipos de datos FP4 y FP6.

También se ha previsto el lanzamiento de una nueva arquitectura CDNA en 2026 para alimentar los aceleradores de la serie AMD Instinct MI400.

A principios de este año, después de que la compañía publicara sus resultados financieros del primer trimestre de 2024 , Su calificó los chips de IA Instinct MI300 como el “producto de mayor crecimiento en la historia de AMD”, y señaló que había superado los mil millones de dólares en ventas totales en menos de dos trimestres.

Basándose en la "ampliación del compromiso con los clientes" de la empresa, Su añadió que la empresa esperaba que los ingresos por GPU del centro de datos superaran los 4.000 millones de dólares en 2024.

El mes pasado, Microsoft anunció que pondría los aceleradores MI300X de AMD a disposición de los clientes a través del servicio de computación en la nube Azure de la compañía, y Scott Guthrie, vicepresidente ejecutivo del grupo de nube e inteligencia artificial de Microsoft, describió el MI300X como "la GPU más rentable que existe en este momento". para Azure OpenAI”.