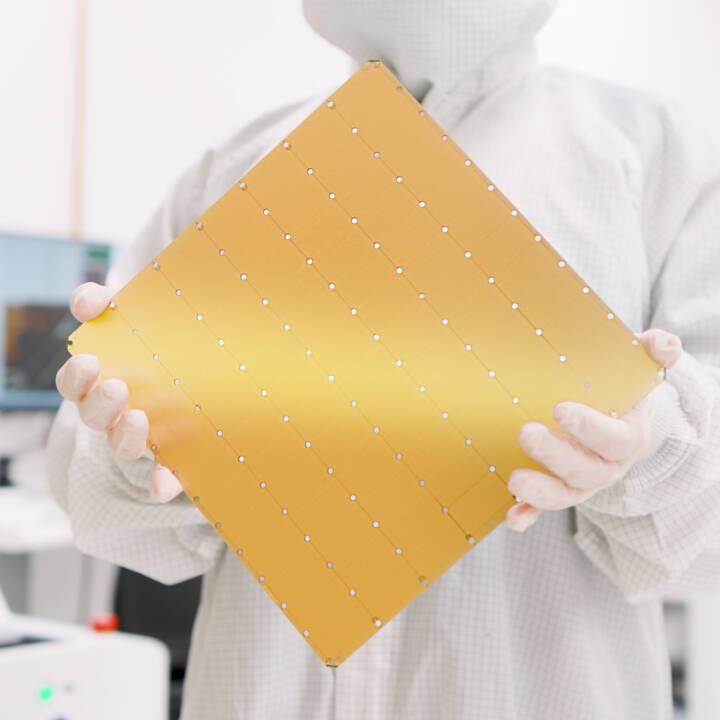

Cerebras Systems ha presentado la última versión de su semiconductor del tamaño de una oblea.

El Wafer Scale Engine 3 cuenta con cuatro mil millones de transistores y 900.000 'núcleos AI', junto con 44 GB de SRAM en el chip.

Cuando se combina con el sistema Cerebras CS-3, la compañía afirma que el chip es capaz de generar 125 petaflops de IA máximos. Esto se puede ampliar hasta 2048 CS-3 en un solo clúster, para unos supuestos 256 exaflops de cómputo de IA.

"No lo construimos a lo grande porque lo grande fuera fácil o lo grande fuera atractivo, pero no solo somos 52 veces más grandes [que una GPU Nvidia], sino que traemos 52 veces la cantidad de núcleos, más de 800 veces la memoria en el chip, y más de tres órdenes de magnitud más de memoria y ancho de banda de comunicación", dijo a DCD el vicepresidente de producto de Cerebras, el Dr. Andy Hock.

En comparación con el WSE-2, "es el mismo cuadrado más grande que podemos cortar del silicio primario circular más grande que podemos comprar", dijo Hock. "Será el doble de rendimiento para el trabajo con IA, dentro del mismo rango de potencia y precio".

La compañía nunca ha revelado oficialmente el precio de sus chips, pero se cree que cuestan entre 2 y 3 millones de dólares. Hock dijo que un solo CS-3 usa 23kW.

Además del nuevo chip, la compañía dijo que ha completado la construcción de Condor Galaxy 2, su segunda supercomputadora en la nube construida como parte de un acuerdo de 900 millones de dólares con G42.

"Ahora estamos construyendo la tercera máquina Condor Galaxy", dijo Hock, y esta incluye CS-3.

Cerebras también se ha asociado con Qualcomm para implementar los chips Cloud AI 100 Ultra para trabajos de inferencia junto a las supercomputadoras de entrenamiento.

Hock ha dicho que la compañía estaba entrenando específicamente modelos para que funcionaran bien en los chips de inferencia, lo que "eliminaría una gran fracción de cálculos innecesarios de operaciones de multiplicación por cero".