La empresa de redes de entrega de contenido (CDN) Cloudflare planea implementar GPU de Nvidia en su red Edge global.

La plataforma está dirigida a aplicaciones de inteligencia artificial, en particular modelos de IA generativa, como los modelos grandes de lenguaje. El modelo de GPU Nvidia no ha sido revelado.

"La inferencia de IA en una red será el punto ideal para muchas empresas: los datos privados permanecen cerca de dondequiera que estén físicamente los usuarios, y al mismo tiempo siguen siendo extremadamente rentables de ejecutar porque están cerca", ha declarado Matthew Prince, CEO y cofundador de Cloudflare. "Con la tecnología GPU de última generación de Nvidia en nuestra red global, estamos haciendo que la inferencia de IA, que antes estaba fuera del alcance de muchos clientes, sea accesible y asequible a nivel mundial".

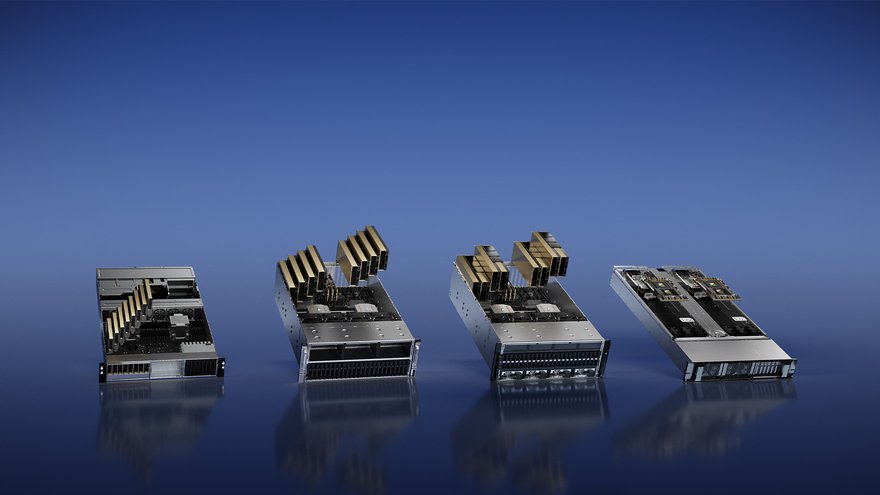

Cloudflare también implementará conmutadores Ethernet Nvidia y utilizará el software de inferencia de pila completa de Nvidia, incluidos Nvidia TensorRT-LLM y el servidor Nvidia Triton Inference.

Las GPU se implementarán en más de 100 ciudades para fines de 2023, y "casi en todas partes se extenderá la red de Cloudflare" para fines de 2024.

"La plataforma de inferencia de Nvidia es fundamental para impulsar la próxima ola de aplicaciones de IA generativa", afirmó Ian Buck, vicepresidente de hiperescala y HPC de Nvidia.

"Con las GPU de Nvidia y el software de IA de Nvidia disponibles en Cloudflare, las empresas podrán crear nuevas experiencias receptivas para los clientes e impulsar la innovación en todas las industrias".

En el lanzamiento, la red no admitirá los modelos proporcionados por el cliente y solo admitirá Llama 2 7B y M2m100-1.2 de Meta, Whisper de OpenAI, Distilbert-sst-2-int8 de Hugging Face, Resnet-50 de Microsoft y bge-base de Baai. -es-v1.5.

Cloudflare planea agregar más modelos en el futuro, con la ayuda de Hugging Face.