Los electrones no son una industria de mucho crecimiento en EE.UU., el segundo mayor mercado de electricidad en el mundo después de China. Las ventas de electricidad crecieron el año pasado, luego de casi una década de mantenerse o caer levemente, pero están apenas 3% por encima del nivel de 2007. Existe un mercado, sin embargo, en el que la demanda de electrones está en auge: los centros de datos. Ese mercado de crecimiento hanbriento de energía, sin embargo, es también al que algunas de las compañías más grandes, más capitalizadas y más innovadoras del mundo están llevando su potencia.

Ahora bien, antes de abordar esa innovación, se debe considerar una ecuación crucial: la tasa de efectividad del uso de la energía, PUE por sus siglas en inglés. La PUE es una medida de la eficiencia del uso de energía en los centros de datos: la proporción entre la energía total utilizada dividida por la energía consumida específicamente para actividades de tecnologías de la información. La PUE teórica ideal es 1, donde el 100% del consumo de energía va a una computación útil. Todo lo demás —transformadores energéticos, suministros de energía ininterrumpibles, iluminación y especialmente refrigeración— utiliza energía pero no para la computación, lo que en consecuencia aumenta la PUE del centro de datos.

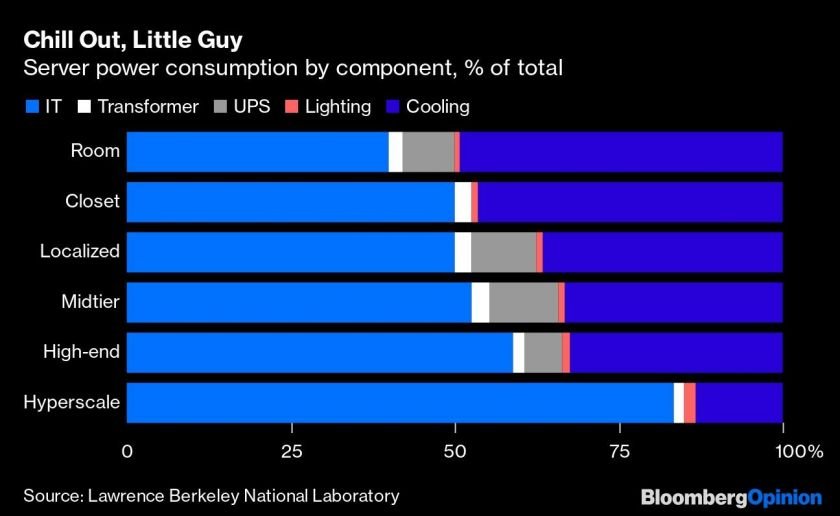

Un estudio de Lawrence Berkeley National Laboratory realizado en 2016 enumeraba las PUE, en el momento, para instalaciones a varias escalas: un servidor en una habitación, un centro de datos extremadamente grande a "hiperescala". Entre más pequeño el servidor, mayor es la tasa y menos la eficiencia. Para los espacios de servidores más pequeños, la PUE está por encima de 2, lo que significa que más de la mitad de la energía se usa para cosas diferentes a la computación. Para la hiperescala, la PUE es de 1,22, lo que significa que la mayor parte de la energía se usa en computación.

Estos son los mismos datos, expresados de un modo un poco diferente, para mostrar el consumo de un servidor o un centro de datos por uso. En ellos se puede observar que los espacios más pequeños usaron más energía en la refrigeración que en la computación. Sin embargo, en los centros de datos a hiperescala, más de 80% del consumo se usó en TI (servidores, redes y almacenamiento), y solo 13% en refrigeración.

Sin embargo, ahora, con tanta computación en la nube (y, en realidad, en los centros de datos a hiperescala), vale la pena calcular las PUE actuales y cuánto pueden acercarse a ese ideal teórico de 1,0.

Una encuesta reciente de Uptime Institute a 1.600 propietarios y operadores de centros de datos halló que la PUE promedio de 2019 es 1,67, y que "las mejoras en la eficiencia energética de las instalaciones de centros de datos se ha estancado he incluso deteriorado un poco en los últimos dos años". Esa PUE significa que el 60% del consumo de electricidad de los centros de datos va a las TI, y el resto a refrigeración, iluminación, etcétera.

No obstante, a algunos operadores les va mucho mejor. Google asegura que sus centros de datos tienen una PUE de 1,1, y algunos centros llegan incluso a 1,06. Las estaciones tienen algo que ver con eso, particularmente porque la mayoría de los centros de datos de Google se encuentran en el hemisferio norte; su centro de datos de Singapur tiene la PUE más alta y es la ubicación menos eficiente. No sorprende, ya que en Singapur hay calor y humedad todo el año.

Una manera clave de disminuir la demanda de refrigeración para los centros de datos es enfriar únicamente a la temperatura en la que las máquinas están cómodas, no a la que los humanos están cómodos. Para Google, esa temperatura es 27 grados centígrados.

Existe otro enfoque; uno que depende de la computación misma: el aprendizaje de máquinas. Google empezó a usar su plataforma de aprendizaje de máquinas DeepMind para el problema de la eficiencia energética de sus centros de datos hace tres años; el año pasado, le dejó el control en efecto a su propia inteligencia artificial:

En 2016, desarrollamos conjuntamente un sistema de recomendaciones basado en IA para mejorar la eficiencia de los ya muy optimizados centros de datos de Google. Nuestra lógica es simple: incluso las mejoras pequeñas pueden significar ahorros energéticos significativos y reducir las emisiones de CO2 para ayudar a combatir el cambio climático.

Ahora estamos llevando este sistema al siguiente nivel: en vez de recomendaciones implementadas por humanos, nuestro sistema de IA controlará directamente la refrigeración de nuestros centros de datos, a la vez que se mantiene bajo vigilancia experta de nuestros operadores de centros de datos. Este primer sistema de control de su tipo basado en la nube está logrando ahorros energéticos seguros en múltiples centros de datos de Google.

Parece probable que este enfoque sea adoptado por Amazon Web Services, Microsoft, IBM y otras importantes firmas de computación en la nube.

Incluso con las ganancias en eficiencia, la demanda de electricidad en los centros de datos es voraz y sigue creciendo; ese crecimiento tiene varias implicaciones para la red eléctrica y los servicios de energía. La primera es que muchos de estos importantes consumidores de electricidad también están contratando energía solar para satisfacer su demanda.

La segunda es que, con muchos centros de datos acumulados en lugares como el norte de Virginia, las cargas de los centros de datos se están convirtiendo en una porción considerable de la demanda del servicio público en ciertos territorios. Una investigación reciente de BloombergNEF halló que los centros de datos podrían representar 15% del pico de demanda de energía en verano de Dominion Energy Inc. para 2024.

En vista de que los operadores de centros de datos tienen todos los incentivos para economizar en electricidad, los servicios públicos deben competir para proporcionar el servicio. Los contratos preferenciales —y confidenciales— por el suministro de energía son una forma de hacerlo, y el resultado sería que otros compradores soporten el costo, como reportó Bloomberg News el año pasado. Las ganancias en eficiencia no significan que la demanda de electricidad de los centros de datos esté disminuyendo. Su escala y su crecimiento es una prueba de su efectividad en el uso de la energía. Sus contratos de electricidad preferenciales, por otra parte, parecen una prueba de su uso efectivo de otro tipo de poder: el poder adquisitivo.

(Fuente: Energy Efficiency Is a Hot Problem for Big Tech’s Data Centers)