Meta ha compartido detalles sobre la próxima generación de su Meta Training and Inference Accelerator (MTIA), chips personalizados diseñados para cargas de trabajo específicas de Meta AI.

La compañía ha dicho que la última versión de sus chips muestra mejoras significativas de rendimiento con respecto al MTIA v1 y ya se está utilizando para respaldar productos y servicios de inteligencia artificial generativa, como los modelos de publicidad de recomendación y clasificación de Meta.

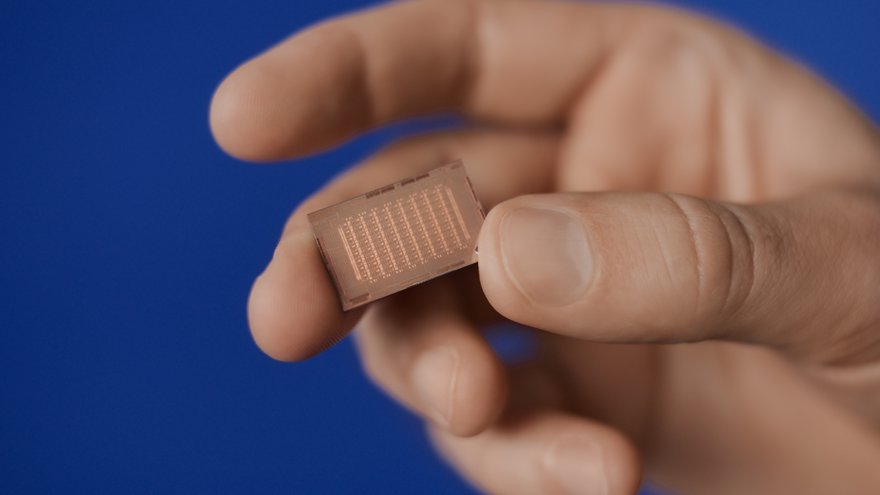

Los MTIA actualizados se basan en nodos de 5 nm y proporcionan 354 máximos (tera de operaciones por segundo) de cálculo de precisión de enteros (8 bits), o 177 teraflops de cálculo de precisión de FP16. Los chips funcionan a 1,35 gigahercios, tienen una potencia de diseño térmico de 90 W y miden aproximadamente 421 milímetros cuadrados.

El MTIA v2 también presenta una arquitectura de red en chip mejorada y contiene 256 MB de memoria en chip y 2,7 TB/s de ancho de banda de memoria en chip, mientras que la capacidad de memoria local es de 384 KB por elemento de procesamiento (PE) y 1 TB/s de banda ancha.

Meta ha dicho que estas actualizaciones representan un aumento de 3,5 veces en el rendimiento de computación densa con respecto al MTIA v1 y una mejora de 7 veces en el rendimiento de computación dispersa. La compañía también triplicó el tamaño del almacenamiento PE local, duplicó la SRAM en el chip, aumentó su ancho de banda en 3,5 veces y duplicó la capacidad de LPDDR5.

Los MTIA estarán alojados en un sistema basado en bastidor que puede contener hasta 72 aceleradores. El sistema consta de tres chasis, cada uno con 12 placas que albergan dos aceleradores cada uno. Meta ha dicho que también ha actualizado la estructura entre los aceleradores y entre el host y los aceleradores a PCIe Gen5 para aumentar el ancho de banda y la escalabilidad de su sistema.

El acelerador de inferencia es parte del programa de desarrollo completo más amplio de Meta para silicio personalizado y específico de dominio que aborda sus cargas de trabajo y sistemas únicos. MTIA ya se ha implementado en sus centros de datos y ahora está sirviendo a modelos en producción.

"Estamos diseñando nuestro silicio personalizado para que funcione en cooperación con nuestra infraestructura existente, así como con hardware nuevo y más avanzado (incluidas las GPU de próxima generación) que podemos aprovechar en el futuro", escribió Joel Coburn, ingeniero de software de Facebook; Eran Tal, director de sistemas de hardware de Facebook; y Nicolaas Viljoen, director técnico principal de sistemas AI/HPC en Meta, en una publicación de blog anunciando MTIA v2.

“Cumplir nuestras ambiciones para nuestro silicio personalizado significa invertir no solo en silicio informático, sino también en ancho de banda de memoria, redes y capacidad, así como en otros sistemas de hardware de próxima generación. Actualmente tenemos varios programas en marcha destinados a ampliar el alcance de MTIA, incluido el soporte para cargas de trabajo GenAI”.

Como se informó por primera vez en febrero de 2024, Meta agregó que la compañía todavía estaba buscando ingenieros para ayudarla a continuar desarrollando sus chips.

El giro de Meta hacia la IA y el cambio de chips obligó a la empresa a rediseñar sus centros de datos teniendo en cuenta las GPU y otros aceleradores y cancelar múltiples proyectos.

La compañía dijo en febrero que espera gastar 37 mil millones de dólares en infraestructura digital en 2024.