Microsoft está implementando el equivalente a cinco supercomputadoras Eagle de 561 petaflops cada mes, según ha afirmado el CTO de Azure, Mark Russinovich.

Eagle apareció por primera vez en el ranking Top500 de las supercomputadoras más poderosas del mundo en noviembre pasado, ocupando el tercer lugar. Con un rendimiento de 561,2 petaflops (HP Linpack), el sistema de Microsoft es también el superordenador en la nube más potente del mundo.

"Aseguramos ese lugar [en el Top500] con 14.400 GPU Nvidia H100 en red y 561 petaflops de cómputo, que en ese momento representaban sólo una fracción de la escala final de esa supercomputadora", dijo Russinovich en Microsoft Build.

"Nuestro sistema de IA es ahora mucho más grande y cambia cada día y cada hora", añadió, aunque Eagle tuvo el mismo rendimiento en el ranking Top500 de este mes, lo que sugiere que Russinovich estaba hablando de la capacidad informática de Azure de manera más amplia.

"Hoy, apenas seis meses después, estamos implementando el equivalente a cinco de esas supercomputadoras cada mes".

Eso representaría el equivalente a 72.000 GPU H100 cada mes, repartidas en el creciente espacio del centro de datos de la empresa, y un total de 2,8 exaflops de cómputo.

"Nuestro cableado de alta velocidad e InfiniBand que conecta nuestras GPU sería lo suficientemente largo como para dar la vuelta a la Tierra al menos cinco veces", añadió. La circunferencia del mundo es de unos 40.000 kilómetros, lo que significa más de 200.000 kilómetros de cableado.

En otra parte de Build, el CTO de Microsoft, Kevin Scott, dio más información sobre las próximas supercomputadoras de la compañía, pero fue mucho menos específico acerca de los números.

"Sólo quería, sin mencionar números, lo cual es difícil de hacer, darles a todos una idea de la ampliación de estos sistemas", dijo Scott. "En 2020, construimos nuestra primera supercomputadora de IA para OpenAI. Es el entorno de supercomputación que construyó GPT-3".

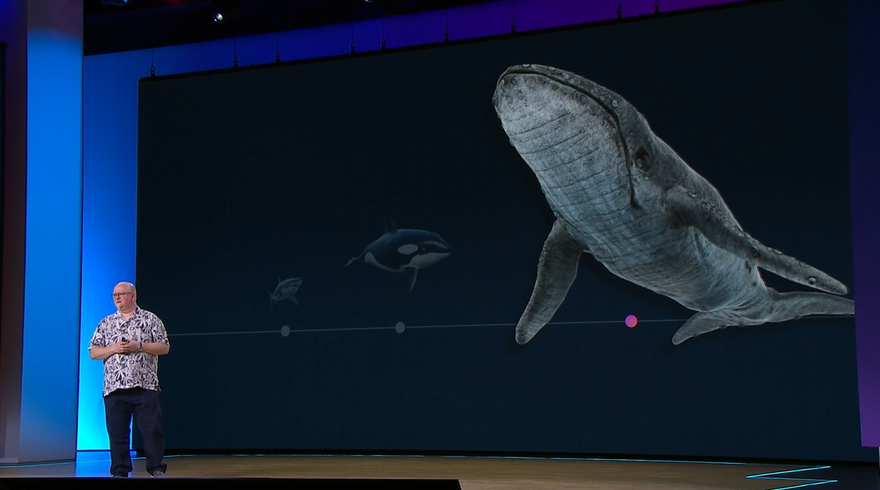

En lugar de números, Scott utilizó la fauna marina como representación de escala. Ese sistema, dijo, podría verse como un tiburón, al menos en tamaño.

"El próximo sistema que construimos, a escala, es aproximadamente del tamaño de una orca. Ese es el sistema que entregamos en 2022 y que entrenó a GPT-4", continuó, probablemente haciendo referencia al sistema Eagle. Si bien su métrica está lejos de ser exacta, las orcas son dos veces más largas y tres veces más pesadas que los grandes tiburones blancos.

"El sistema que acabamos de implementar es tan grande, en términos de escala, como una ballena". Ampliando la métrica, una ballena azul (la ballena que representó) es más del doble de larga que una orca y unas 25 veces más pesada.

Scott también dijo que el desarrollo de modelos ha demostrado que todavía había un vínculo claro entre la cantidad de computación utilizada para desarrollar nuevos modelos y las capacidades de las que son capaces. "Y resulta que se puede construir una gran cantidad de IA con una supercomputadora del tamaño de una ballena", dijo.

"Por lo tanto, una de las cosas en las que quiero que la gente realmente piense con claridad es en que la próxima muestra está por llegar, y esta supercomputadora del tamaño de una ballena está trabajando arduamente en este momento para construir el próximo conjunto de capacidades que vamos a implementar."

A principios de este año, se informó que Microsoft y OpenAI estaban considerando construir una supercomputadora 'Stargate' de 100 mil millones de dólares , pero el mes pasado Scott calificó las especulaciones sobre supercomputación como "graciosamente erróneas".