Por Adrien Viaud, Gerente de Tecnología Senior en Kingston Technology:

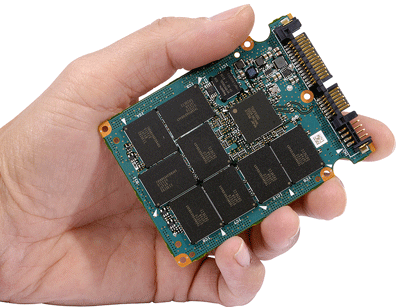

Las unidades de estado sólido (SSD) ahora son casi omnipresentes en las computadoras de escritorio y portátiles, pero les ha llevado mucho más tiempo a las SSD tener la misma implementación generalizada en el centro de datos. Los requisitos completamente diferentes de las aplicaciones de la nube y del centro de datos significan que tres aspectos de la tecnología SSD han tenido que alcanzar la madurez antes de que los SSD puedan ser un reemplazo viable para los discos duros: costo, confiabilidad y capacidad.

Ahora la tecnología ha alcanzado una masa crítica, y el centro de datos solo SSD no es solo una realidad, sino cada vez más el futuro del almacenamiento empresarial. Y, a diferencia de los primeros días de los SSD, hoy hay muchas opciones.

SSD en el centro de datos

Inicialmente, las SSD del servidor funcionaron mejor como caché y almacenamiento en caliente para mezclar con discos giratorios SAS o SATA, pero ahora con NAND de mayor densidad, las SSD del servidor alcanzan capacidades de hasta 3.84TB, unidades AIC rápidas basadas en NVMe y estándares entrantes como U.2, allí es un cambio hacia las matrices All-Flash (AFA), que eliminan los discos giratorios por completo.

No es difícil ver por qué ocurre este cambio. Un solo SSD puede superar a varios discos giratorios y consume menos energía. Por lo tanto, le permite consolidar servidores y reducir la huella física general de un rack de almacenamiento.

Sin embargo, los SSD en el centro de datos dependen de un conjunto diferente de métricas para las PC de consumo. A diferencia de una PC cliente típica, donde es poco probable que el uso requiera un rendimiento constante las 24 horas, los 7 días de la semana, un centro de datos debe ser capaz de cumplir con este requisito y experimentar una mayor demanda dependiendo de la aplicación.

Piensa en el Black Friday, por ejemplo. El mayor día del año para el comercio electrónico ve una enorme cantidad de compras en línea, una enorme cantidad de tráfico y un aumento en la cantidad de transacciones que manejan los centros de datos.

Las unidades de centro de datos deben ser capaces de enfrentar este desafío, con confiabilidad y rendimiento diario constante durante todo el período de garantía. La resistencia es clave, al igual que el rendimiento constante de IOPS. Sin embargo, con una aplicación diferente, como uno de los servicios populares de transmisión de video que requiere una red de visualización de contenido, la baja latencia predecible se convierte en un requisito clave. Una vez más, se necesitan IOPS consistentes para esta situación, combinados con calidad de servicio (QOS). Los clientes de servidores y centros de datos ahora pueden elegir entre SSD SATA rápidos y confiables, que tienen los beneficios del intercambio en caliente, opciones de redundancia flexibles y gran escalabilidad gracias a múltiples compartimientos de unidades por servidor y los últimos discos NVMe AIC de alto rendimiento que ofrecen los más rápidos rendimiento posible de la tecnología NAND.

Sin embargo, aunque SATA es actualmente el estándar para la implementación de SSD, está en declive. El canal todavía está muy enfocado en la implementación generalizada de SATA, y la transición a los niveles de rendimiento de NVMe llevará algún tiempo, hasta 24 meses para algunos clientes del canal.

Y pronto, el estándar U.2 hará que esta elección sea mucho más interesante, lo que cerrará la brecha entre estas dos categorías de SSD. Ofrece el rendimiento de NVMe, con los mismos beneficios de escala, redundancia e intercambio en caliente que actualmente solo son posibles desde SATA.

Aplicaciones de borde

Sin embargo, la llegada de AFA es solo una forma en que el almacenamiento empresarial está cambiando. Edge está teniendo un gran impacto en la configuración global del centro de datos, y estas instalaciones de ultra rendimiento están diseñadas para operar en una escala menor que los centros principales centralizados a los que están conectados. En un centro de datos perimetral, el tipo de SSD que se usa depende de la aplicación, ya sea que existan requisitos para un alto rendimiento de lectura / escritura (por ejemplo, transmisión de medios), acceso aleatorio (acceso a la base de datos) u otros.

Vemos que DRAM también juega un papel para los centros de datos de borde, donde la alta capacidad de memoria y el ancho de banda son cruciales para la aplicación. Y la conectividad de red bien diseñada es, por supuesto, crucial para permitir bajas latencias entre los centros de datos periféricos y centralizados.

Edge es solo un ejemplo de cómo está evolucionando el centro de datos, y las tecnologías futuras podrían conducir a nuevas permutaciones de almacenamiento empresarial. En este momento, la atención se centra en la informática tradicional Intel y AMD x86, pero existen argumentos convincentes para la especialización que afectarán la implementación de SSD. Vemos potencial para tecnologías de refrigeración líquida con nodos de computación basados en FPGA, aprendizaje automático, tecnología 5G con infraestructuras informáticas más inteligentes y más.

Aquí también se necesita un almacenamiento rápido, en algunos casos las consideraciones principales son factores de forma física específicos (huella pequeña) y una mayor tolerancia a factores ambientales más amplios.

En última instancia, la evolución del centro de datos está impulsada por la demanda y, en el futuro, es probable que estas demandas cambien una vez más, ya que las aplicaciones completamente nuevas tendrán requisitos de almacenamiento diferentes. La gran flexibilidad de la implementación de SSD, junto con las tecnologías emergentes, asegurará que se satisfagan estas necesidades.