Durante décadas, el centro de datos se ha considerado el nexo de la red. Para las empresas, los operadores de telecomunicaciones, los operadores de cable y, más recientemente, los proveedores de servicios como Google y Facebook, el centro de datos era el corazón y el músculo de la TI. Además, la aparición de la nube ha enfatizado la importancia central del centro de datos moderno.

Pero preste atención y escuchará los rumores del cambio. Las redes aumentan su soporte para 5G e IoT, los gerentes de TI se están enfocando en el Edge y la creciente necesidad de ubicar más capacidad y potencia de procesamiento más cerca de los usuarios finales. Mientras lo hacen, están reevaluando el papel de sus centros de datos.

En 2018, Gartner predijo que para 2025, el 75 por ciento de los datos generados por la empresa se crearán y procesarán en el Edge, en comparación con solo el 10 por ciento en 2018. Al mismo tiempo, el volumen de datos se está preparando para alcanzar otra velocidad. Se espera que un solo automóvil autónomo produzca un promedio de 4.000 GB de datos por hora de conducción.

Las redes ahora están luchando para determinar la mejor manera de soportar grandes aumentos en el volumen de tráfico basado en el Edge, así como la demanda de rendimiento de latencia digital única, sin torpedear la inversión en los centros de datos existentes. Una gran inversión en enlaces de red este-oeste y nodos redundantes de igual a igual es parte de la respuesta, al igual que generar más potencia de procesamiento donde se crean los datos. Pero, ¿qué pasa con los centros de datos? ¿Qué papel jugarán?

El circuito de retroalimentación AI / ML

El caso comercial futuro de los centros de datos de hiperescala y de nube radica en su capacidad de almacenamiento y procesamiento masivo. A medida que la actividad se intensifica en el Edge, se necesitará la potencia del centro de datos para crear los algoritmos que permitan procesar los datos. En un mundo potenciado por IoT, no se puede subestimar la importancia de la inteligencia artificial (IA) y el aprendizaje automático (ML). Tampoco puede el papel del centro de datos para que esto suceda.

La producción de los algoritmos necesarios para impulsar la inteligencia artificial y el aprendizaje automático requiere cantidades masivas de procesamiento de datos. Los centros de datos centrales han comenzado a implementar CPU más robustas junto con unidades de procesamiento de tensores (TPU) u otro hardware especializado. Además, las aplicaciones de IA y ML a menudo requieren redes de alta velocidad y alta capacidad, con una capa de conmutación avanzada que alimenta a los bancos de servidores que trabajan en el mismo problema. Los modelos de IA y ML son el producto de este esfuerzo intensivo.

En el otro extremo del proceso, los modelos de IA y ML deben ubicarse donde puedan tener el mayor impacto comercial. Para las aplicaciones de IA empresarial como el reconocimiento facial, por ejemplo, los requisitos de latencia ultrabaja exigen que se implementen localmente, no en el núcleo. Pero los modelos también deben ajustarse periódicamente, por lo que los datos recopilados en el Edge se retroalimentan al centro de datos para actualizar y refinar los algoritmos.

¿Jugar en la caja de arena o ser dueño de ella?

El ciclo de retroalimentación AI / ML es un ejemplo de cómo los centros de datos necesitarán soportar un ecosistema de red más expansivo y diverso. Para los jugadores más grandes en el espacio del centro de datos de hiperescala, esto significa adaptarse a un entorno colaborativo más distribuido. Quieren permitir que sus clientes implementen IA o ML en el Edge, en su plataforma, pero no necesariamente en sus propias instalaciones.

Proveedores como AWS, Microsoft y Google ahora están implementando su hardware en la nube más cerca de las ubicaciones de los clientes, incluidas las oficinas centrales y los centros de datos empresariales privados en las instalaciones. Esto permite a los clientes crear y ejecutar aplicaciones basadas en la nube en cualquiera de estas instalaciones, utilizando la plataforma de hiperescala y una combinación de instalaciones Edge. Debido a que estas plataformas también están integradas en muchos de los sistemas de los operadores, los clientes también pueden ejecutar sus aplicaciones en cualquier lugar donde el operador tenga esta presencia. Este modelo, aún en su infancia, proporciona más flexibilidad para el cliente al tiempo que permite a los proveedores brindar un mejor soporte al Edge.

Otro enfoque de ecosistema implementado por Vapor IO, proporciona un modelo de negocio con centros de datos alojados con recursos de red, almacenamiento y computación estandarizados. Los clientes más pequeños, una empresa de juegos, por ejemplo, pueden ubicar una máquina virtual cerca de sus clientes y ejecutar sus aplicaciones utilizando el ecosistema Vapor IO. Servicios como este podrían operar en un modelo de participación en los ingresos, lo que podría ser un paradigma atractivo para una pequeña empresa que intenta desarrollar el ecosistema de servicios de Edge.

Desafíos fundamentales

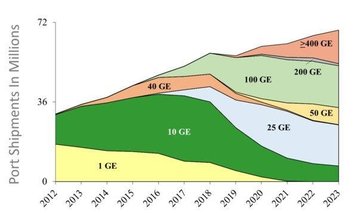

A medida que se enfoca la visión de las redes de próxima generación, la industria debe enfrentar los desafíos de implementación. Dentro del centro de datos, sabemos cómo se ve: las conexiones del servidor pasarán de 50 Gb por carril a 100 Gb, el ancho de banda de conmutación aumentará a 256 TB y la migración a la tecnología de 100 Gb nos llevará a módulos conectables de 800 Gb.

Lo que está menos claro es cómo la industria diseña la infraestructura desde el núcleo hasta el Edge, específicamente, cómo ejecutamos las arquitecturas DCI y los enlaces metropolitanos y de largo alcance y cómo admitimos los nodos de Edge peer-to-peer de alta redundancia. El otro desafío es desarrollar las capacidades de orquestación y automatización necesarias para administrar y enrutar grandes cantidades de tráfico. Estos problemas están al frente y al centro a medida que la industria avanza hacia una red habilitada para 5G / IoT.

Llegando juntos

Lo que sí sabemos con certeza es que el trabajo de construir e implementar redes de próxima generación implicará un esfuerzo coordinado. El centro de datos, cuya capacidad para ofrecer almacenamiento y procesamiento de alto volumen y bajo costo no se puede duplicar en el Edge, ciertamente tendrá un papel importante que desempeñar. Pero, a medida que más instalaciones distribuidas ubicadas en el Edge soportan una mayor parte de la carga, la función del centro de datos evoluciona aún más para convertirse en parte de este ecosistema más grande y distribuido.

Alrededor del 10 por ciento de los datos generados por la empresa se crean y procesan fuera de un centro de datos centralizado tradicional o en la nube. Para 2025, Gartner predice que esta cifra alcanzará el 75 por ciento.

Unirlo todo será una red de fibra más rápida y confiable, comenzando en el núcleo y extendiéndose hasta los Edge más lejanos de la red. Será esta plataforma de cableado y conectividad, impulsada por PAM4 y tecnologías de procesamiento coherente, con óptica coherente digital y empaquetada, y empaquetada en cableado compacto y de ultra alta densidad, la que proporcionará el hilo continuo de rendimiento constante en todo momento.

Ya sea que se trate de un centro de datos de hiperescala, un jugador centrado en el Edge o un proveedor de infraestructura, en la red de próxima generación habrá mucho espacio y trabajo para todos. Las rodajas no se hacen más pequeñas; el pastel solo se hace más grande.