La eficiencia energética es el héroe desconocido de la informática.

Todos conocemos la historia del rendimiento. La tecnología móvil de vanguardia alguna vez significó una calculadora con un botón de raíz cuadrada dedicado. Pronto, los automóviles autónomos, los dispositivos médicos inteligentes y los edificios inteligentes cambiarán la estructura de la vida cotidiana.

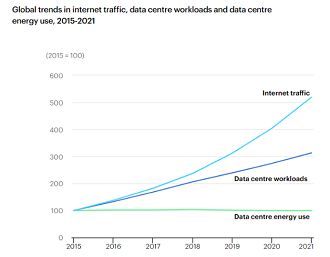

Pero esos avances solo han sido posibles porque los teléfonos móviles, los servidores y otros dispositivos han duplicado la cantidad de trabajo que realizan aproximadamente en vatios de potencia cada 2 a 2,5 años. Las cargas de trabajo del centro de datos casi se han triplicado desde 2015, mientras que el tráfico de Internet ha crecido 5 veces, pero el consumo de energía del centro de datos, gracias a una serie de avances que pueden no aparecer en las portadas, se ha mantenido relativamente estable en alrededor de 198 mil millones de kilovatios hora.

¿Es esto inusual? ¿El consumo de combustible de su automóvil se duplica cada pocos años?

Otra forma de ver el fenómeno de eficiencia energética es a través de la lente de la densidad de cálculo. El aumento de la densidad de cómputo aumenta los recursos disponibles por centro de datos, lo que a su vez significa un ROI potencialmente mejor para los operadores, un mejor precio para las aplicaciones que aprovechan la infraestructura y una adopción más rápida por parte de los clientes. Sin embargo, un bastidor solo puede acomodar una cantidad finita de energía y calor: la productividad aumenta a través del trabajo por vatio o se necesita más espacio y servidores. El ciclo virtuoso de repente comienza a crujir.

La próxima ola de dispositivos inteligentes agrega un nuevo nivel de urgencia a la búsqueda de rendimiento por vatio. La electricidad es a menudo del 30 al 50 por ciento de los costos operativos de los centros de datos. Sin embargo, el informe State of the Edge 2020 estima que se necesitarán 102 GW de nueva capacidad de energía, o básicamente una red del tamaño de California, para 2028 para atender estas nuevas aplicaciones. Como resultado, varias industrias podrían luchar o nadar dependiendo de lo que ocurra con eficiencia y densidad.

¿Cuáles son algunas de las ideas para doblar la curva?

Más núcleos

En los últimos 15 años, la mayoría ha seguido un camino de "afuera hacia adentro" hacia una mejor eficiencia y densidad. Primero, las empresas modernizaron los edificios para mejorar el flujo de aire. Luego, las láminas de plástico sobre los estantes redujeron aún más los presupuestos de enfriamiento. Luego entraron en los bastidores para eliminar los servidores zombie que se ejecutan en su lugar. Luego vinieron las GPU y los aceleradores flash para impulsar las operaciones por vatio.

La siguiente capa de la cebolla gira en torno al príncipe heredero de los componentes de la computadora. Si, el procesador. Los centros de datos que implementan servidores con procesadores alimentan una gran cantidad de núcleos de cómputo con eficiencia energética en lugar de cantidades más pequeñas de núcleos más robustos. Dicho de otra manera, están cambiando de una carrera en una velocidad más baja a altas RPM a una velocidad más alta a menos RPM.

El nuevo procesador de sistema en chip (SoC) Graviton2 de Amazon Web Services (AWS) consta de 64 núcleos de cómputo que se pueden combinar con otros núcleos especialmente diseñados para cientos, si no miles, de núcleos por rack. Fujitsu en noviembre reclamó el puesto # 1 en la lista Green 500 con Fugaku, una supercomputadora de alto rendimiento que contiene casi 37.000 núcleos de eficiencia energética que pueden realizar 16,876 gigaflops por vatio. Ampere mostró recientemente cómo puede caber 3680 núcleos en un bastidor, o más de 2,5 veces más de lo normal.

Agregar NPU

Al igual que los zapatos Stan Smith de la década de 1970, el coprocesador está de vuelta. La tecnología de procesamiento de redes neuronales, que puede venir en forma de extensiones de vectores, circuitos integrados o una NPU dedicada, está específicamente diseñada para realizar la multiplicación de matrices de manera eficiente en el cálculo (y, por lo tanto, la energía). Las CPU clásicas no lo son. Deloitte predice que los envíos de NPU crecerán un 20 por ciento por año, más del doble de la TCAC a largo plazo para semiconductores.

La tecnología NPU podría ser crítica para reducir los recursos necesarios para extraer información de video e imágenes con IA. El video ya representa aproximadamente el 75 por ciento del tráfico de Internet hoy y engullirá el 82 por ciento para 2022. El reconocimiento facial y el análisis en tiempo real solo se sumarán al peso.

Aprovechar el Edge

Los centros de datos basados en la nube, en resumen, son el lugar más eficiente para colocar cargas informáticas. Las cargas de trabajo se pueden consolidar agresivamente y se puede utilizar el equipo más eficiente para poblarlas.

Lamentablemente, no vivimos en un mundo abstracto. Un aumento de 15 minutos en la demanda de energía en una nube, por ejemplo, podría conducir a cargas molestas (y exorbitantes) de potencia máxima que no ocurrirían si las cargas se extendieran a la periferia. Mientras tanto, la conducción autónoma y las fábricas habilitadas para IA también requerirán una infraestructura de borde sofisticada.

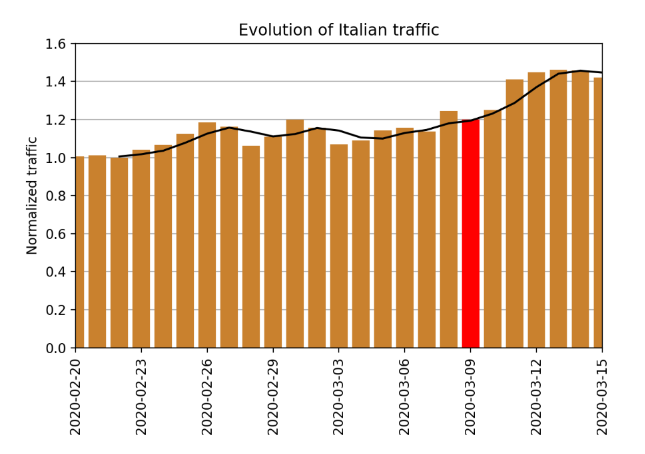

Y en una crisis nacional o mundial, como la actual pandemia de Covid-19, una perspectiva centrada en la nube podría significar conexiones lentas y feeds de video irregulares. Por ejemplo, el tráfico de Internet en los EE.UU aumentó temporalmente en un 20 por ciento después de que se declarara un estado de emergencia nacional el 13 de marzo, según Cloudflare, mientras que el tráfico diario de Italia aumentó en un 20-40 por ciento (ver imagen).

Y dado que la videoconferencia probablemente sea más común en un mundo posterior a la pandemia, la necesidad de una ventaja profunda es aún más evidente.

Esta tendencia requerirá que los transportistas y otros desarrollen técnicas para cambiar las cargas de forma fluida para maximizar la utilización y minimizar el tráfico de energía y de red. Ehsan Ahvar, Anne-Cécile Orgerie y Adrien Lebre del Inria Project Lab escribieron recientemente que administrar tareas relacionadas con IoT en servidores distribuidos puede consumir entre un 14 y un 25 por ciento menos de energía que un centro de datos basado en la nube. ¿Por qué? Menos saltos de red, menores cargas de enfriamiento y un mejor uso de los activos de computación en barbecho.

Del mismo modo, los investigadores de la Universidad de Leeds descubrieron que el consumo de energía para las tareas de video de vigilancia podría reducirse hasta en un 32 por ciento mediante la recolección de la capacidad disponible de los activos cercanos de IoT y computación de niebla durante períodos lentos.

Calculando los efectos auxiliares

Más trabajo por vatio significa potencialmente un mejor uso de bienes raíces, que puede ser un costo premium en las ciudades o en el límite. Un cambio a las energías renovables puede reducir los costos de energía y agua, así como reducir las tarifas regulatorias. Los empleados, los consumidores y los inversores exigen que las empresas reduzcan su propia huella de carbono y compren a proveedores más ecológicos.

Los centros de datos aún no enfrentan una crisis, pero quieren comenzar a pensar en los cambios que se avecinan ahora.

Por Chris Bergey, SVP / GM de infraestructura en Arm