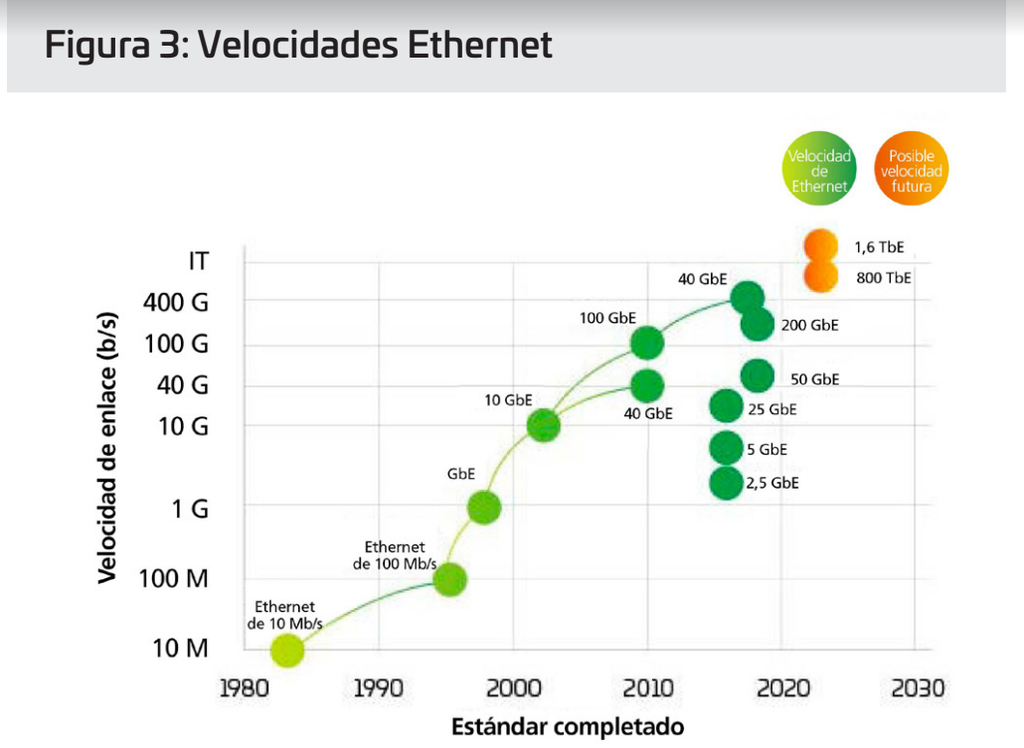

Solo porque esté funcionando a 40 G o incluso a 100G hoy en día, no se deje llevar por una falsa sensación de seguridad. Si algo hemos aprendido de la evolución de los centros de datos, es que la velocidad del cambio, ya sea en el ancho de banda, la densidad de la fibra o las velocidades de la línea, se acelera exponencialmente. La transición hacia los 400G está más cerca de lo que piensa.

¿No lo ve tan claro? Añada el número de puertos de 10 G (o más rápidos) que admite actualmente e imagine que progresan hasta los 100G: así se dará cuenta de que la necesidad de 400G (y más) no está tan injustificada.

¿Qué significa esto para los centros de datos?

A medida que los administradores de centros de datos miran al horizonte, los signos de una evolución basada en la nube asoman por todas partes.

Dentro de la propia nube, el hardware está cambiando. Las múltiples redes dispares típicas en un centro de datos heredado han evolucionado hasta convertirse en un entorno más virtualizado que utiliza recursos de hardware agrupados y gestión impulsada por software. Esta virtualización está impulsando la necesidad de dirigir el acceso y la actividad de las aplicaciones de la manera más rápida posible, forzando a muchos administradores de red a preguntarse lo siguiente: “¿Cómo diseño mi infraestructura para soportar estas aplicaciones cloud-first?”

La respuesta comienza con la habilitación de velocidades más altas por canal. La progresión de 25 a 50 a 100G y superior es clave para llegar a 400G y más allá, y ya ha empezado a reemplazar la ruta de migración tradicional de 1/10 G. Pero se necesita mucho más que aumentar la velocidad de los canales. Tenemos que profundizar un poco más.

¿Quién (y qué) está impulsando el cambio a velocidades más altas?

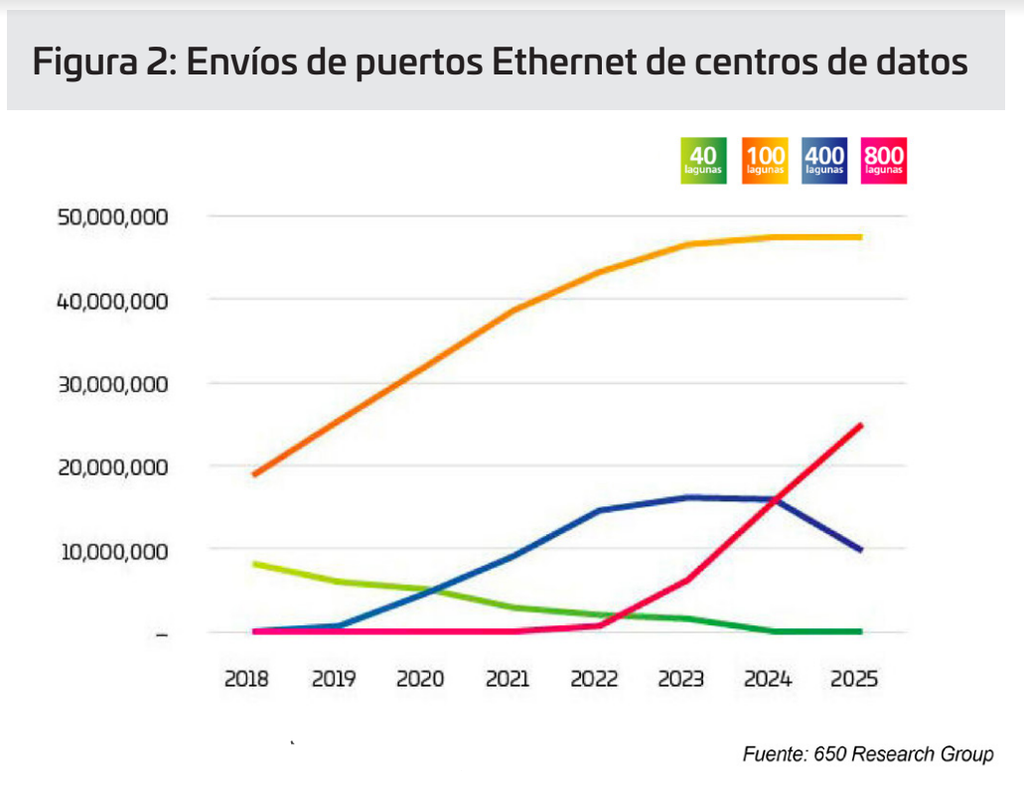

El sector está llegando a un punto de inflexión. La adopción de los 400G ha aumentado muy rápidamente, pero se espera que en poco tiempo la de los 800G comience a acelerarse incluso más rápidamente que la de 400G. Como cabe esperar, no hay una respuesta sencilla a la pregunta de quién o qué está impulsando la transición hacia los 400G. Hay una variedad de factores que influyen en esto, muchos de los cuales están entrelazados. Las nuevas tecnologías permiten un menor coste por bit cuando aumentan las velocidades de canal. Los datos más recientes pronostican que las velocidades de canal de 100G se combinarán con puertos de conmutación octal para traer opciones de 800G al mercado a partir de 2022. Sin embargo, estos puertos se utilizan de varias maneras, como se ilustra en los datos de Light Counting6, donde 400G y 800G se dividen principalmente en 4X o 8X 100G. Esta exitosa aplicación es el impulsor inicial de estas nuevas aplicaciones ópticas.

La transición hacia los 400G es un esfuerzo grupal

En la red de datos, la capacidad es una cuestión de control y equilibrio entre servidores, switches y conectividad. Cada uno empuja al otro a ser más rápido y menos costoso, para realizar un seguimiento eficiente de la demanda producida por el aumento de conjuntos de datos, la IA y el ML. Durante años, la tecnología de switches fue el principal cuello de botella. Con la introducción de StrataXGS® Tomahawk® 3 de Broadcom, los gestores de centros de datos pueden ahora aumentar las velocidades de conmutación y enrutamiento hasta 12,8 terabits por segundo (Tbps) y reducir su coste por puerto en un 75 %. El switch chip Tomahawk 4 de Broadcom, con un ancho de banda de 25 Tbps, proporciona al sector de centros de datos más capacidad de conmutación para mantenerse por delante de las crecientes cargas de trabajo de IA y ML. En la actualidad, este chip es compatible con puertos 64x 400G; pero con una capacidad de 25,6 Tb/s, la tecnología de semiconductores nos lleva por un camino en el que en el futuro podríamos ver puertos 32x 800G en un solo chip. 32, que por coincidencia es el número máximo de QSFP-DD u OSFP (transceptores de 800G) que se pueden presentar en una placa frontal de switch 1U.

Por lo tanto, ahora el factor limitante es la capacidad de procesamiento de la CPU. ¿Correcto? Pues no. A principios de este año, NVIDIA presentó su nuevo chip Ampere para servidores. Resulta que los procesadores utilizados en los juegos son perfectos para manejar la formación y el procesamiento necesario para la IA y el aprendizaje automático (ML). Según NVIDIA, una máquina basada en Ampere puede hacer el trabajo de 120 servidores con tecnología Intel.

Con switches y servidores disponibles para admitir 400G y 800G para cuando se necesiten, la presión cambia ahora a la capa física para mantener la red equilibrada. La norma IEEE 802.3bs, aprobada en 2017, allanó el camino para Ethernet 200G y 400G. Sin embargo, el IEEE acaba de completar su evaluación para emprender el desarrollo de 800G y más. El IEEE ha iniciado un grupo de estudio para identificar los objetivos de las aplicaciones más allá de los 400G y, dado el tiempo necesario para desarrollar y adoptar nuevos estándares, es posible que ya vayamos tarde. El sector está trabajando ahora conjuntamente para introducir los 800G y comienza a trabajar hacia los 1,6 T y más allá, a la vez que mejora la potencia y el coste por bit.