Con la cantidad de datos que fluyen por los Data Centers, las aplicaciones que consumen muchos recursos están definiendo las necesidades y la evolución de estos centros, con muchas implicaciones en la infraestructura de red.

En este artículo, analizaremos las tecnologías y aplicaciones de la próxima generación que van a impulsar este cambio y cómo conseguir los fundamentos de la infraestructura adecuados, empezando ahora.

No es ningún secreto que la cantidad de datos que fluyen hacia y a través de los Data Center está aumentando en órdenes de magnitud cada año.

Esto por sí solo está obligando a los gestores de redes a replantearse todo, desde su planta de fibra exterior hasta las topologías de red utilizadas para mover, enrutar y distribuir petabytes de datos. Al mismo tiempo, la propia naturaleza de los datos también está cambiando rápidamente.

La tendencia hacia un mayor número de aplicaciones de los clientes que requieren un rendimiento ultra fiable y de muy baja latencia y más recursos de procesamiento en el Edge ha puesto en cuestión la definición de lo que es -o necesita ser- un Data Center. El resultado es una interesante dicotomía.

Por un lado, el paso a un entorno virtualizado más eficiente basado en la nube permite a los Data Center aprovechar las economías de escala. Al agrupar los equipos activos en una estructura centralizada (no muy diferente de una red móvil C-RAN), los Data Center pueden obtener ahorros sustanciales en términos de energía, mantenimiento y otras eficiencias operativas.

Por otro lado, la afluencia de datos ultrafiables y de latencia ultrabaja procedentes de aplicaciones como la automatización de la fabricación, los vehículos autoconducidos y la telecirugía demuestra que es necesario situar más recursos informáticos cerca de los dispositivos y las personas que producen y consumen los datos.

Esta tendencia dicta el empuje de más equipos activos hacia el "Edge". Pero, ¿Qué significa exactamente eso? ¿Dónde está exactamente el Edge? ¿Gabinetes localizados y distribuidos a nivel de calle, cada uno con unos pocos racks? ¿Data Centers metropolitanos con una docena de filas? ¿O una combinación de ambos? La respuesta estará relacionada con el rendimiento de la latencia que requieren estas nuevas aplicaciones.

Para 2025, el 85% de las estrategias de infraestructura integrarán opciones de entrega en las instalaciones, en la nube y en el borde, en comparación con el 20% en 2020.

En un artículo sobre 2020, Gartner señala que, para comprender y abordar adecuadamente la metamorfosis que se está produciendo, hay que empezar por los requisitos de la carga de trabajo de los datos, y no por la composición física actual del paisaje del Data Center.

En otras palabras, el papel del departamento de TI no es diseñar, desplegar y mantener los Data Center; su trabajo es satisfacer los requisitos de carga de trabajo dispares de las distintas aplicaciones y clientes de la forma más rentable y sostenible posible. La forma debe seguir a la función, no dictarla. Así pues, veamos las aplicaciones que ya están informando el futuro del diseño de los Data Centers.

Cómo las aplicaciones que usan los recursos de manera intensiva están definiendo el Data Center

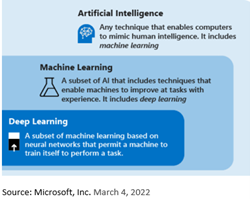

La inteligencia artificial (IA) y sus derivados, impulsados por los casos de uso más intensivo de recursos, como los asistentes virtuales y el reconocimiento facial, están cambiando literalmente las arquitecturas de los Data Centers.

Los complejos algoritmos necesarios para impulsar estas aplicaciones se desarrollan y modelan en lo más profundo del núcleo del Data Center, y luego se trasladan a los nodos de borde. Ocasionalmente, el volcado de datos del borde se envían de vuelta al núcleo y se utilizan para perfeccionar el algoritmo antes de volver a enviarlo al borde.

A medida que el ciclo de mejora continua/despliegue continuo (CI/CD) se repite con éxito, los algoritmos y las aplicaciones se vuelven más eficientes.

Este flujo y reflujo de datos entre el Edge y el núcleo está impulsado por el lugar en el que debe estar la carga de trabajo para procesar y entregar la información de la manera más eficiente. Las cargas de trabajo, a su vez, se ven impulsadas por el despliegue de la Internet de las cosas en el Edge, la automatización industrial y aplicaciones aún desconocidas del futuro próximo.

Es en este complejo entorno donde los gestores y diseñadores de redes deben planificar e implementar las infraestructuras de la capa física necesarias para conectar y soportar estos ecosistemas durante los próximos años.

Con los despliegues de IA, aprendizaje automático (ML) y aprendizaje profundo en aumento, es fundamental clavar la infraestructura desde el principio.

A medida que los algoritmos se hacen más rápidos, más precisos y más exactos, estas tecnologías se ampliarán. La infraestructura adecuada lo permitirá, minimizando el impacto en el ecosistema y evolucionando con el tiempo sin tener que retocar toda la red.

El reto es que el entorno cambia con tanta rapidez que, en muchos aspectos, nosotros, como industria, tenemos que construir el avión mientras lo volamos.

Pero no estamos volando a ciegas, conocemos algunos de los obstáculos inmediatos que tenemos que superar. Por ejemplo, ya estamos viendo que los despliegues iniciales de IA y ML hacen que los requisitos de velocidad de la red del servidor sean de 200 gigas y más.

Sabemos que los fabricantes de conmutadores están favoreciendo los nuevos conectores MPO16 que admiten ocho carriles con interconexiones de 16 fibras. Actualmente, esto supone un potencial de 800G por transceptor de red o, quizás, ocho servidores que se conectan a 100G desde un único transceptor.

Más carriles significan más capacidad por conmutador, lo que supone un menor coste y un menor consumo de energía.

En la actualidad, un único conmutador de alta radicación admite 256 carriles a 100G por carril, lo que supone 25,6T de capacidad. Desplegados en el borde, estos conmutadores proporcionan el mismo ancho de banda que varios modelos de última generación, más que suficiente para soportar un gran número de servidores o dispositivos.

Añadir un segundo conmutador en el Edge proporciona la redundancia y la capacidad de cinco o seis conmutadores de modelos anteriores. Y lo que es más importante, permite al centro de datos crear la capacidad de Edge necesaria para soportar el bucle de CI/CD esencial para perfeccionar los algoritmos de AL y ML.

Un gran reto es que el ancho de banda es finito y caro, por lo que los gestores de red deben priorizar qué información debe ser canalizada de vuelta al núcleo y qué puede permanecer en el Edge.

Incluso definir la ubicación del Edge puede ser difícil. En el caso de un hiperescalador, el Edge puede estar en un MTDC, en un armario a pie de calle o en una instalación de fabricación situada a kilómetros del núcleo. La variedad de escenarios de despliegue y los requisitos de ancho de banda dictan las capacidades y configuraciones de la infraestructura.

Implicaciones para la infraestructura de red

Adaptarse a los nuevos requisitos del núcleo al extremo significa que las infraestructuras de red deben ser más rápidas y flexibles. Ya estamos viendo cómo las velocidades de 400G y superiores están afectando a los diseños de las redes.

A partir de 400G, se están diseñando más aplicaciones para un cableado de 16 fibras. Esto está provocando un cambio de la conectividad tradicional basada en cuádruples a los diseños octales construidos en los separadores MPO de 16 fibras.

Una configuración de 16 fibras duplica el número de salidas por transceptor y proporciona soporte a largo plazo de 400G a 800G, 1,6T y más.

El diseño de 16 fibras, que incluye transceptores, cables troncales y módulos de distribución, se convertirá en la base de las conexiones core-to-Edge de mayor velocidad.

Al mismo tiempo, los Data Center necesitan más flexibilidad de diseño a la hora de redistribuir la capacidad de fibra y responder a los cambios en la asignación de recursos.

Una forma de conseguirlo es desarrollar una modularidad integrada en los componentes del panel. Un diseño en el que todos los componentes del panel sean esencialmente intercambiables y estén diseñados para encajar en un único panel común permite a los diseñadores e instaladores reconfigurar y desplegar rápidamente la capacidad de fibra lo más rápido posible y con el menor coste. Asimismo, permite al Data Center racionalizar el inventario de la infraestructura y los costes asociados.

La infraestructura correcta empieza ahora

Las tecnologías y aplicaciones de próxima generación están impulsadas por eficiencias y capacidades que aún estamos desarrollando.

Como industria, cuando pensamos en tener que reequipar miles de Data Centers muy grandes para proporcionar ese nivel de flexibilidad de alta eficiencia, acertar desde el primer día se convierte en un imperativo.

Los cimientos de la infraestructura deben estar en su sitio antes de que lleguemos demasiado lejos en el camino. De lo contrario, las infraestructuras que deberían permitir el crecimiento lo impedirán.

Eso no significa que tengamos que tener el 100% de las capacidades necesarias desde el principio. Pero sí necesitamos entender cómo es la estructura, para poder construir lo que se necesita, donde se necesita y antes de que lo necesitemos.

En CommScope, hemos utilizado más de 40 años de experiencia en el diseño de infraestructuras y las aportaciones de clientes y socios para desarrollar una plataforma de fibra única que creemos que puede servir de modelo para un crecimiento sostenible a largo plazo.

Para obtener más información, visite la página Insights de CommScope.